邏輯迴歸

| 此條目需要精通或熟悉相關主題的編者參與及協助編輯。 (2016年9月17日) |

邏輯迴歸(英語:Logistic regression,又譯作邏輯斯迴歸、羅吉斯迴歸、邏輯斯諦迴歸、對數幾率迴歸),在統計學中是一種對數幾率模型(英語:Logit model,又譯作邏輯斯諦模型、評定模型、分類評定模型),是離散選擇法模型之一,屬於多元變量分析範疇,是社會學、生物統計學、臨床、數量心理學、計量經濟學、市場營銷等統計實證分析的常用方法。

通過使事件的對數發生率(log-odd)成為一個或多個自變量的線性組合,對事件發生的概率進行建模。形式上,在二元邏輯回歸中,有一個二元因變量,由指示變量編碼,其中兩個值標記為「0」和「1」,而自變量每個都可以是二元變量(兩個類,由指示變量)或連續變量(任何實值)。標記為「1」的值的相應概率可以在0和1之間變化;將對數發生率轉換為概率的函數就是邏輯斯諦函數,因此得名。對數發生率單位稱為logit,來自logistic unit。[1]

二元變量在統計學中廣泛用於對某一類別或事件發生概率的建模,例如團隊獲勝概率、患者健康概率等,而其中,邏輯模型則自大約 1970年以來最常用的二元回歸模型。[2]當存在兩個以上可能值(例如圖像是否是貓、狗、獅子等)時,二元變量可以推廣為分類變量,並且二元邏輯回歸推廣為多項邏輯回歸。如果多個類別是有序的,則可以使用序數邏輯回歸。邏輯回歸模型本身只是簡單地根據輸入對輸出概率進行建模,並不執行統計分類。[3]

例子[編輯]

以一個例子說明邏輯回歸如何解決實際問題:

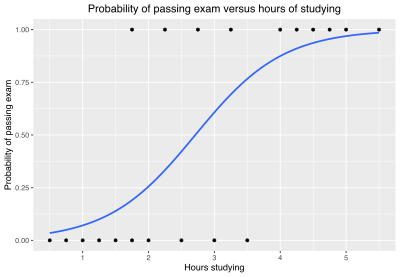

一個小組20名學生,各自花費0~6小時準備考試,他們不同的學習時數如何影響通過考試的概率?

問題中的因變量是考試「通過」或者「掛科」,這是用邏輯回歸的原因,雖然分別用「1」和「0」表示,但這兩個數字不代表基數。如果問題發生變化,用0-100的成績(基數)代替通過、掛科,則可以使用回歸分析。

下表顯示每個學生花費在學習上的小時數,以及他們通過(1)或掛科(0)。

| 小時(xk) | 0.50 | 0.75 | 1.00 | 1.25 | 1.50 | 1.75 | 1.75 | 2.00 | 2.25 | 2.50 | 2.75 | 3.00 | 3.25 | 3.50 | 4.00 | 4.25 | 4.50 | 4.75 | 5.00 | 5.50 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 通過(yk) | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 1 | 0 | 1 | 0 | 1 | 0 | 1 | 1 | 1 | 1 | 1 | 1 |

對學習時間(xk)和測試結果(yk = 1 表示通過,0 表示掛科)組成的數據進行擬合。數據點由下標k索引,該下標從1到20。x變量稱為「自變量」,y變量稱為「分類變量」,由「通過」或「失敗」兩個類別組成,分別對應於分類值1和0。

模型[編輯]

| 統計學系列條目 |

| 迴歸分析 |

|---|

|

| 模型 |

| 估計 |

| 背景 |

邏輯函數形式為:

其中μ是位置參數(曲線的中點,其中),s是尺度參數。該式可重寫為:

稱為截距,是直線的y截距。是反比例參數或速率參數,是作為"x"函數的對數發生率的"y"截距和斜率。反之,,並且。

邏輯斯諦分布公式[編輯]

其中參數常用最大似然估計。

IIA假設[編輯]

全名為Independent and irrelevant alternatives假設,也稱作IIA效應,指Logit模型中的各個可選項是獨立的。

IIA假設示例[編輯]

市場上有A,B,C三個商品相互競爭,分別占有市場份額:60%,30%和10%,三者比例為:6:3:1

一個新產品D引入市場,有能力占有20%的市場——

如果滿足IIA假設,各個產品獨立作用,互不關聯:新產品D占有20%的市場份額,剩下的80%在A、B、C之間按照6:3:1的比例瓜分,分別占有48%,24%和8%。

如果不滿足IIA假設,比如新產品D跟產品B相似度高,則新產品D的CP值高而奪去產品B的部分市場(總份額的20%),則產品B剩餘10%,而產品A和C的市場份額保持60%和10%不變。

滿足IIA假設的優點[編輯]

IIA假設的檢驗[編輯]

Hausman檢驗[編輯]

一般化模型的檢驗[編輯]

IIA問題的解決方法[編輯]

| 機器學習與資料探勘 |

|---|

|

多項式Probit模型[編輯]

一般化極值模型[編輯]

可以將可選項間的相關性建模

巢式Logit模型[編輯]

巢式(Nested)表示可選項被分作不同的組,組與組之間不相關,組內的可選項相關,相關程度用1-λg來表示(1-λg越大,相關程度越高)

對偶組合Logit模型[編輯]

一般化分簇Logit模型[編輯]

混合Logit模型[編輯]

應用[編輯]

配體結合分析[編輯]

配體結合分析的典型校準曲線是S形的,下邊界(漸近線)靠近背景信號(非特異性結合),而上漸近線靠近最大的飽和響應。 四參數邏輯模型通常是擬合這種形狀校準曲線的首選,可以準確描述測量信號值與分析物濃度之間的S形關係。當不對稱性明顯時會添加第五個參數,但可能會導致擬合算法變得不穩定。[4]

二類評定模型(Binary Logit Model)[編輯]

- 僅有兩個可選項:V1n,V2n

| 變量類型 | 統計量 | 組別比較 | 回歸模型 |

|---|---|---|---|

| numerical | mean | t-test/ANOVA | 線性回歸 |

| categorical | percentage | Chi-square test | 邏輯斯諦回歸 |

| persontime | KM estimates (survival curves) |

Log-rank test | 比例風險回歸 |

參考書目[編輯]

- Agresti, Alan: Categorical Data Analysis. New York: Wiley, 1990.

- Amemiya, T., 1985, Advanced Econometrics,Harvard University Press.

- Hosmer, D. W. and S. Lemeshow: Applied logistic regression. New York; Chichester, Wiley, 2000.

參見[編輯]

外部連結[編輯]

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

參考[編輯]

- ^ Hosmer, David W.; Lemeshow, Stanley. Applied logistic regression. Wiley series in probability and statistics 2. ed., [Nachdr.] New York: Wiley. 200. ISBN 978-0-471-35632-5. 缺少或

|title=為空 (幫助) - ^ Cramer, J.S. The Origins of Logistic Regression. SSRN Electronic Journal. 2003. ISSN 1556-5068. doi:10.2139/ssrn.360300 (英語).

- ^ Walker, Strother H.; Duncan, David B. Estimation of the Probability of an Event as a Function of Several Independent Variables. Biometrika. 1967-06, 54 (1/2). doi:10.2307/2333860.

- ^ Findlay, John W. A.; Dillard, Robert F. Appropriate calibration curve fitting in ligand binding assays. The AAPS Journal. 2007-06, 9 (2). ISSN 1550-7416. doi:10.1208/aapsj0902029.