在機率論 和統計學 中,二項式分布 (英語:binomial distribution )是一種離散 機率分布 ,描述在進行獨立 隨機試驗 時,每次試驗都有相同機率 「成功」的情況下,獲得成功的總次數。擲硬幣 十次出現五次正面的機率、產品合格率

99

%

{\displaystyle \,99\%\,}

只有「成功」和「失敗」兩種可能結果 ,每次重複時成功機率不變的獨立隨機試驗稱作伯努利試驗 ,例如上述的擲硬幣出現正面或反面、對產品進行抽樣檢查時抽到正品或次品。伯努利試驗作為理論模型,其前提在現實中無法完全得到滿足,比如生產線會磨損,因此每件產品合格的機率並非固定。儘管如此,二項式分布給出的機率通常足以用於提供有用的推斷;即使在已知前提沒有滿足的場合,二項式分布也能用於參考和比較。二項式分布的應用出現在遺傳學 、質量控制 等領域之中。

若隨機變數

X

{\displaystyle \,X\,}

機率質量函數

Pr

(

X

=

k

)

=

(

n

k

)

p

k

(

1

−

p

)

n

−

k

(

k

=

0

,

1

,

…

,

n

)

,

{\displaystyle \Pr(X=k)={n \choose k}p^{k}(1-p)^{n-k}\quad (k=0,1,\ldots ,n),}

其中

n

{\displaystyle \,n\,}

正整數 、

0

≤

p

≤

1

{\displaystyle \,0\leq p\leq 1\,}

X

{\displaystyle \,X\,}

母數 為

n

,

p

{\displaystyle \,n,p\,}

X

∼

B

(

n

,

p

)

{\displaystyle \,X\sim \operatorname {B} (n,p)\,}

X

∼

Bin

(

n

,

p

)

{\displaystyle \,X\sim \operatorname {Bin} (n,p)\,}

1

−

p

{\displaystyle \,1-p\,}

q

{\displaystyle \,q\,}

進行

n

{\displaystyle \,n\,}

獨立 伯努利試驗 的結果可以由

n

{\displaystyle \,n\,}

S

{\displaystyle \,S\,}

F

{\displaystyle \,F\,}

S

S

F

S

F

{\displaystyle SSFSF}

表示五次試驗中第一、二、四次的結果為成功,其餘為失敗。設每次試驗成功的機率為

p

{\displaystyle \,p\,}

1

−

p

{\displaystyle \,1-p\,}

k

{\displaystyle \,k\,}

S

{\displaystyle \,S\,}

n

−

k

{\displaystyle \,n-k\,}

F

{\displaystyle \,F\,}

p

k

(

1

−

p

)

n

−

k

{\displaystyle \,p^{k}(1-p)^{n-k}\,}

從

n

{\displaystyle \,n\,}

元素 中選出含

k

{\displaystyle \,k\,}

子集 的方法數量等於二項式係數

(

n

k

)

=

n

!

k

!

(

n

−

k

)

!

.

{\displaystyle {n \choose k}={\frac {n!}{k!(n-k)!}}.}

而每種對

k

{\displaystyle \,k\,}

S

{\displaystyle \,S\,}

n

−

k

{\displaystyle \,n-k\,}

F

{\displaystyle \,F\,}

n

{\displaystyle \,n\,}

k

{\displaystyle \,k\,}

S

{\displaystyle \,S\,}

(

n

k

)

{\displaystyle \,{n \choose k}\,}

(

n

k

)

p

k

(

1

−

p

)

n

−

k

.

{\displaystyle {n \choose k}p^{k}(1-p)^{n-k}.}

二項式分布是最早得到研究的機率分布之一。丹麥統計學家安德斯·哈爾德 認為其歷史可以追溯至布萊茲·帕斯卡 與皮埃爾·德·費馬 於1654年對點數分配問題 的討論:兩名玩家贏得每局遊戲的機會相同,贏得一定局數的勝者可獲得獎金,但比賽僅進行了數局,尚未分出勝負就被迫中斷,則獎金該如何分配?帕斯卡認為,獎金的分配應當基於玩家距離勝利所差的局數:若一名玩家還需

r

{\displaystyle \,r\,}

s

{\displaystyle \,s\,}

r

+

s

−

1

{\displaystyle \,r+s-1\,}

2

r

+

s

−

1

{\displaystyle \,2^{r+s-1}\,}

p

=

1

/

2

{\displaystyle \,p=1/2\,}

對二項式分布機率的推導為雅各布·伯努利 於《猜度術 機率論 的奠基性作品。伯努利還在其中首次給出了弱大數法則 的嚴格證明。對二項式分布的常態 近似則是由亞伯拉罕·棣美弗 發現,這一工作於1733年完成,於1738年出版在其著作《機遇論

母數為

n

,

p

{\displaystyle \,n,p\,}

期望值 為

n

p

{\displaystyle \,np\,}

變異數 為

n

p

(

1

−

p

)

{\displaystyle \,np(1-p)\,}

機率母函數 為

G

(

z

)

=

(

1

−

p

+

p

z

)

n

,

{\displaystyle G(z)=(1-p+pz)^{n},}

動差母函數 為

M

X

(

t

)

=

(

1

−

p

+

p

e

t

)

n

,

{\displaystyle M_{X}(t)=(1-p+pe^{t})^{n},}

特徵函數 為

φ

X

(

t

)

=

(

1

−

p

+

p

e

i

t

)

n

.

{\displaystyle \varphi _{X}(t)=(1-p+pe^{it})^{n}.}

母數

n

=

1

{\displaystyle \,n=1\,}

伯努利分布 。多項分布 超幾何分布 的極限形式。

二項式分布的和 [ 編輯 ] 若

X

1

,

X

2

{\displaystyle \,X_{1},X_{2}\,}

n

1

,

p

{\displaystyle \,n_{1},p\,}

n

2

,

p

{\displaystyle \,n_{2},p\,}

X

1

+

X

2

{\displaystyle \,X_{1}+X_{2}\,}

n

1

+

n

2

{\displaystyle \,n_{1}+n_{2}\,}

X

1

+

X

2

{\displaystyle \,X_{1}+X_{2}\,}

n

1

+

n

2

,

p

{\displaystyle \,n_{1}+n_{2},p\,}

X

1

+

X

2

=

k

{\displaystyle \,X_{1}+X_{2}=k\,}

X

1

{\displaystyle \,X_{1}\,}

條件機率分布 是母數為

k

,

n

1

,

n

1

+

n

2

{\displaystyle \,k,n_{1},n_{1}+n_{2}\,}

計算

Pr

(

X

=

k

)

{\displaystyle \,\Pr(X=k)\,}

Pr

(

X

=

k

+

1

)

{\displaystyle \,\Pr(X=k+1)\,}

Pr

(

X

=

k

+

1

)

Pr

(

X

=

k

)

=

(

n

−

k

)

p

(

k

+

1

)

(

1

−

p

)

(

k

=

0

,

1

,

…

,

n

−

1

)

,

{\displaystyle {\frac {\Pr(X=k+1)}{\Pr(X=k)}}={\frac {(n-k)p}{(k+1)(1-p)}}\quad (k=0,1,\ldots ,n-1),}

因此,當

k

<

(

n

+

1

)

p

−

1

{\displaystyle \,k<(n+1)p-1\,}

Pr

(

X

=

k

)

{\displaystyle \,\Pr(X=k)\,}

k

{\displaystyle \,k\,}

k

>

(

n

+

1

)

p

−

1

{\displaystyle \,k>(n+1)p-1\,}

Pr

(

X

=

k

)

{\displaystyle \,\Pr(X=k)\,}

k

{\displaystyle \,k\,}

眾數 為

(

n

+

1

)

p

{\displaystyle \,(n+1)p\,}

下取整

⌊

(

n

+

1

)

p

⌋

{\displaystyle \,\lfloor (n+1)p\rfloor \,}

(

n

+

1

)

p

{\displaystyle \,(n+1)p\,}

(

n

+

1

)

p

{\displaystyle \,(n+1)p\,}

(

n

+

1

)

p

−

1

{\displaystyle \,(n+1)p-1\,}

p

<

(

n

+

1

)

−

1

{\displaystyle \,p<(n+1)^{-1}\,}

0

{\displaystyle \,0\,}

中位數 [ 編輯 ] 二項式分布的中位數

m

{\displaystyle \,m\,}

n

p

{\displaystyle \,np\,}

取整 之間,即

⌊

n

p

⌋

≤

m

≤

⌈

n

p

⌉

{\displaystyle \,\lfloor np\rfloor \leq m\leq \lceil np\rceil \,}

n

p

{\displaystyle \,np\,}

m

=

n

p

{\displaystyle \,m=np\,}

m

{\displaystyle \,m\,}

n

p

{\displaystyle \,np\,}

|

m

−

n

p

|

<

max

{

p

,

1

−

p

}

.

{\displaystyle |m-np|<\max\{p,1-p\}.}

若

p

>

ln

2

{\displaystyle \,p>\ln 2\,}

p

<

1

−

ln

2

{\displaystyle \,p<1-\ln 2\,}

|

m

−

n

p

|

<

ln

2.

{\displaystyle |m-np|<\ln 2.}

若

n

{\displaystyle \,n\,}

奇數 、

p

=

1

/

2

{\displaystyle \,p=1/2\,}

(

n

−

1

)

/

2

{\displaystyle \,(n-1)/2\,}

(

n

+

1

)

/

2

{\displaystyle \,(n+1)/2\,}

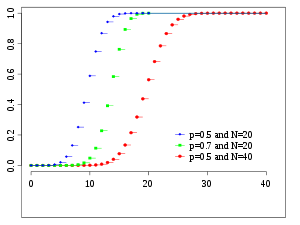

累積分布函數 [ 編輯 ] 二項式分布的累積分布函數 和尾機率可以用正則化不完全貝塔函數 表示為

Pr

(

X

≤

k

)

=

I

1

−

p

(

n

−

⌊

k

⌋

,

⌊

k

⌋

+

1

)

,

{\displaystyle \Pr(X\leq k)=I_{1-p}(n-\lfloor k\rfloor ,\lfloor k\rfloor +1),}

Pr

(

X

≥

k

)

=

I

p

(

⌈

k

⌉

,

n

−

⌈

k

⌉

+

1

)

.

{\displaystyle \Pr(X\geq k)=I_{p}(\lceil k\rceil ,n-\lceil k\rceil +1).}

二項式分布的

r

{\displaystyle \,r\,}

原動差 滿足

μ

r

′

=

E

[

X

r

]

=

∑

j

=

0

r

S

(

r

,

j

)

n

!

p

j

(

n

−

j

)

!

,

{\displaystyle \mu '_{r}=E[X^{r}]=\sum _{j=0}^{r}{\frac {S(r,j)n!p^{j}}{(n-j)!}},}

其中

S

(

r

,

j

)

{\displaystyle \,S(r,j)\,}

第二類 史特靈數 。具體而言,

μ

1

′

=

n

p

,

{\displaystyle \mu '_{1}=np,}

μ

2

′

=

n

p

+

n

(

n

−

1

)

p

2

,

{\displaystyle \mu '_{2}=np+n(n-1)p^{2},}

μ

3

′

=

n

p

+

3

n

(

n

−

1

)

p

2

+

n

(

n

−

1

)

(

n

−

2

)

p

3

,

{\displaystyle \mu '_{3}=np+3n(n-1)p^{2}+n(n-1)(n-2)p^{3},}

μ

4

′

=

n

p

+

7

n

(

n

−

1

)

p

2

+

6

n

(

n

−

1

)

(

n

−

2

)

p

3

+

n

(

n

−

1

)

(

n

−

2

)

(

n

−

3

)

p

4

.

{\displaystyle \mu '_{4}=np+7n(n-1)p^{2}+6n(n-1)(n-2)p^{3}+n(n-1)(n-2)(n-3)p^{4}.}

其低階主動差 為

μ

2

=

n

p

(

1

−

p

)

,

{\displaystyle \mu _{2}=np(1-p),}

μ

3

=

n

p

(

1

−

p

)

(

1

−

2

p

)

,

{\displaystyle \mu _{3}=np(1-p)(1-2p),}

μ

4

=

3

[

n

p

(

1

−

p

)

]

2

+

n

p

(

1

−

p

)

[

1

−

6

p

(

1

−

p

)

]

.

{\displaystyle \mu _{4}=3[np(1-p)]^{2}+np(1-p)[1-6p(1-p)].}

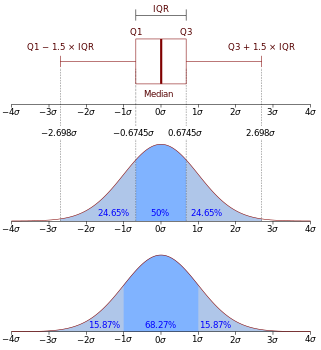

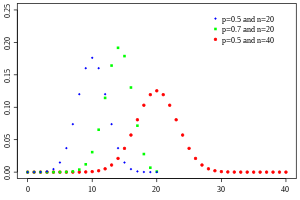

常態近似 [ 編輯 ]

n

=

6

{\displaystyle n=6}

p

=

0.5

{\displaystyle p=0.5}

二項式分布 及其常態近似標準二項式分布

X

′

=

X

−

n

p

n

p

(

1

−

p

)

{\displaystyle X'={\frac {X-np}{\sqrt {np(1-p)}}}}

在

n

→

∞

{\displaystyle \,n\to \infty \,}

趨近 於標準常態分布 。這一結果稱作棣美弗-拉普拉斯定理 中央極限定理 的特殊形式。基於這一定理可以得到

Pr

(

α

<

X

−

n

p

n

p

(

1

−

p

)

<

β

)

→

Φ

(

β

)

−

Φ

(

α

)

,

{\displaystyle \Pr(\alpha <{\frac {X-np}{\sqrt {np(1-p)}}}<\beta )\to \Phi (\beta )-\Phi (\alpha ),}

其中

Φ

{\displaystyle \,\Phi \,}

累積分布函數 。

常態分布為連續機率分布 ,在近似二項式分布這類離散機率分布時,可將端點向外偏移

0.5

{\displaystyle \,0.5\,}

Pr

(

X

≤

k

)

≈

Φ

(

k

+

0.5

−

n

p

n

p

(

1

−

p

)

)

,

{\displaystyle \Pr(X\leq k)\approx \Phi \left({\frac {k+0.5-np}{\sqrt {np(1-p)}}}\right),}

從而提升近似的準確性,這種技巧稱作連續性校正 經驗法則 ,例如要求

n

p

(

1

−

p

)

>

9

{\displaystyle \,np(1-p)>9\,}

p

≤

0.5

{\displaystyle \,p\leq 0.5\,}

n

p

>

5

{\displaystyle \,np>5\,}

p

>

0.5

{\displaystyle \,p>0.5\,}

n

(

1

−

p

)

>

5

{\displaystyle \,n(1-p)>5\,}

卜瓦松近似 [ 編輯 ] 當

n

→

∞

,

p

→

0

{\displaystyle \,n\to \infty ,p\to 0\,}

n

p

{\displaystyle \,np\,}

n

p

{\displaystyle \,np\,}

卜瓦松分布 。以此為基礎可以得到

Pr

(

X

≤

k

)

≈

e

−

n

p

∑

j

=

0

k

(

n

p

)

j

j

!

.

{\displaystyle \Pr(X\leq k)\approx e^{-np}\sum _{j=0}^{k}{\frac {(np)^{j}}{j!}}.}

二項式分布與其卜瓦松近似之間的絕對誤差存在上界。若隨機變數

X

{\displaystyle \,X\,}

n

,

p

{\displaystyle \,n,p\,}

Y

{\displaystyle \,Y\,}

n

p

{\displaystyle \,np\,}

∑

k

=

0

∞

‖

Pr

(

X

=

k

)

−

Pr

(

Y

=

k

)

‖

≤

min

{

2

n

p

2

,

3

p

}

.

{\displaystyle \sum _{k=0}^{\infty }\|\Pr(X=k)-\Pr(Y=k)\|\leq \min\{2np^{2},3p\}.}

母數估計 [ 編輯 ] 點估計 [ 編輯 ] 通常母數

n

{\displaystyle \,n\,}

X

{\displaystyle \,X\,}

p

{\displaystyle \,p\,}

X

{\displaystyle \,X\,}

x

{\displaystyle \,x\,}

動差估計 和最大概似估計 對母數

p

{\displaystyle \,p\,}

估計量 均為

x

n

{\displaystyle \,{\frac {x}{n}}\,}

不偏 的。

母數

p

{\displaystyle \,p\,}

貝氏估計量 事前分布 。若使用連續型均勻分布 作為事前分布,即假設

0

{\displaystyle \,0\,}

1

{\displaystyle \,1\,}

區間 包含

p

{\displaystyle \,p\,}

p

^

=

x

+

1

n

+

2

.

{\displaystyle {\widehat {p}}={\frac {x+1}{n+2}}.}

這被稱作拉普拉斯–貝氏估計量 皮埃爾-西蒙·拉普拉斯 用於估計在太陽 連續升起

n

{\displaystyle \,n\,}

若使用母數為

α

,

β

{\displaystyle \,\alpha ,\beta \,}

貝塔分布 作為事前分布,則後驗均值估計量為

p

^

=

α

+

x

+

1

α

+

β

+

n

+

2

.

{\displaystyle {\widehat {p}}={\frac {\alpha +x+1}{\alpha +\beta +n+2}}.}

採用貝塔分布作為事前分布時,事後分布 亦是貝塔分布,即貝塔分布為二項式分布的共軛先驗 。

區間估計 [ 編輯 ] 若要對母數

p

{\displaystyle \,p\,}

區間 形式給出估計,通過求解

∑

j

=

x

n

(

n

j

)

p

L

j

(

1

−

p

L

)

n

−

j

=

α

2

,

{\displaystyle \sum _{j=x}^{n}{n \choose j}p_{L}^{j}(1-p_{L})^{n-j}={\frac {\alpha }{2}},}

∑

j

=

0

x

(

n

j

)

p

U

j

(

1

−

p

U

)

n

−

j

=

α

2

,

{\displaystyle \sum _{j=0}^{x}{n \choose j}p_{U}^{j}(1-p_{U})^{n-j}={\frac {\alpha }{2}},}

所得的區間

(

p

L

,

p

U

)

{\displaystyle \,(p_{L},p_{U})\,}

1

−

α

{\displaystyle \,1-\alpha \,}

信賴區間 ,稱作克洛珀-皮爾森區間(Clopper-Pearson interval )。

常態分布可以用於推導近似的信賴區間。若用

λ

α

/

2

{\displaystyle \,\lambda _{\alpha /2}\,}

1

−

α

2

{\displaystyle \,1-{\frac {\alpha }{2}}\,}

分位數 ,即

Φ

(

λ

α

/

2

)

=

1

−

α

2

{\displaystyle \,\Phi (\lambda _{\alpha /2})=1-{\frac {\alpha }{2}}\,}

x

n

±

λ

α

/

2

n

x

n

(

1

−

x

n

)

.

{\displaystyle {\frac {x}{n}}\pm {\frac {\lambda _{\alpha /2}}{\sqrt {n}}}{\sqrt {{\frac {x}{n}}\left(1-{\frac {x}{n}}\right)}}.}

參考文獻 [ 編輯 ]

Blyth, C. R. Approximate Binomial Confidence Limits . Journal of the American Statistical Association. 1986, 81 : 843–855. doi:10.1080/01621459.1986.10478343 (英語) . Chew, V. Point Estimation of the Parameter of the Binomial Distribution. The American Statistician. 1971, 25 (5): 47–50. doi:10.1080/00031305.1971.10477305 (英語) . Feller, W. An Introduction to Probability Theory and Its Applications, Volume 1, Third Edition. Wiley. 1968. ISBN 0-471-25708-7(英語) . Hald, A. A History of Probability and Statistics and Their Applications before 1750. Wiley. 2003. ISBN 0-471-47129-1(英語) . Hamza, K. The Smallest Uniform Upper Bound on the Distance Between the Mean and the Median of the Binomial and Poisson Distributions. Statistics and Probability Letters. 1995, 23 : 21–25. doi:10.1016/0167-7152(94)00090-U (英語) . Johnson, N. L.; Kemp, A. W.; Kotz, S. Univariate Discrete Distributions, Third Edition. Wiley. 2005. ISBN 0-471-27246-9(英語) . Kaas, R.; Buhrman, J. M. Mean, Median and Mode in Binomial Distributions. Statistica Neerlandica. 1980, 34 (1): 13–18. doi:10.1111/j.1467-9574.1980.tb00681.x (英語) . Schader, M.; Schmid, F. Two Rules of Thumb for the Approximation of the Binomial Distribution by the Normal Distribution. The American Statistician. 1989, 43 (1): 23–24. doi:10.1080/00031305.1989.10475601 (英語) . Sheu, S. S. The Poisson Approximation to the Binomial Distribution . The American Statistician. 1984, 38 (3): 206–207. doi:10.1080/00031305.1984.10483202 (英語) . Stigler, S. M. The History of Statistics: The Measurement of Uncertainty before 1900 . Harvard University Press. 1986. ISBN 0-674-40340-1(英語) .

![{\displaystyle \mu '_{r}=E[X^{r}]=\sum _{j=0}^{r}{\frac {S(r,j)n!p^{j}}{(n-j)!}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9eb616ff48171dc34a4694e4951109f642940d8e)

![{\displaystyle \mu _{4}=3[np(1-p)]^{2}+np(1-p)[1-6p(1-p)].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/afc6efa1ae3b379bf77653d9627e8a7d86a9060a)