DALL-E

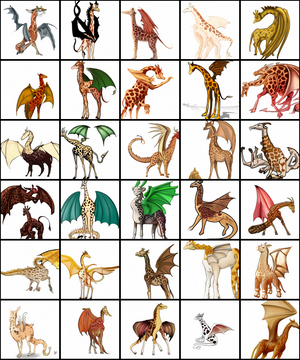

DALL-E生成的一系列長頸鹿與龍的嵌合體圖像 | |

| 原作者 | OpenAI |

|---|---|

| 首次發佈 | 2021年1月5日 |

| 類型 | Transformer模型 |

| 網站 | openai |

DALL-E是一個可以通過文本描述生成圖像的人工智能程序,於2021年1月5日由OpenAI發佈。

DALL-E通過120億參數[1]版本的GPT-3 Transformer模型來理解自然語言輸入(例如「五邊形形狀的綠色皮革錢包」或「一隻悲傷水豚的等距視圖」)並生成相應的圖片。[2]它既可以生成現實的對象(例如「帶有藍色草莓圖像的彩色玻璃窗」),也能夠生成現實中不存在的對象(例如「具有豪豬紋理的立方體」)。[3][4][5]它的名字是2008年動畫電影WALL-E(瓦力)和20世紀西班牙加泰羅尼亞畫家薩爾瓦多·達利(Salvador Dalí)之混成詞。[2][1]

自2000年代以來,已有其他許多神經網絡有生成逼真圖像的能力。[2]而DALL-E的特點在於它能夠通過純文本描述生成這樣逼真的圖像。[2]

OpenAI尚未發佈DALL-E模型的原始碼,不過OpenAI在其網站上提供了DALL-E演示,可以查看部分文本描述的輸出圖像。[1]除了官方版本的DALL-E,另有DALL-E Mini等其他人發佈的以少量數據訓練的開源替代方案。[6]

《麻省理工科技評論》認為OpenAI的目標之一是「讓語言模型更好地掌握人類用來理解事物的日常概念」。[7]

歷史

[編輯]DALL-E模型最初於2021年1月5日由OpenAI發佈。[7]

2022年4月,OpenAI宣佈了新版本的DALL-E 2,聲稱它可以從文本描述中生成照片般逼真的圖像,另外還有一個允許對輸出進行簡單修改的編輯器。根據OpenAI的公告,該程序仍處於研究階段,訪問權限僅限於小部分測試版用戶。該模型有時仍會犯一些人類不會犯的嚴重錯誤。[8]OpenAI稱DALL-E 2是一個「可以從文本描述中生成原創、逼真的圖像和藝術」的模型。[9]

CLIP模型

[編輯]DALL-E是與CLIP(Contrastive Language-Image Pre-training,對比圖文預訓練)模型一起開發並向公眾發佈的。[7]CLIP是一個單獨的模型,其作用是理解輸出圖像並為其打分。[2]DALL-E生成的圖像由CLIP模型進行篩選,以呈現最高品質的圖像。[7]

架構

[編輯]GPT模型最初由OpenAI於2018年開發[10],其使用了Transformer架構。第二版的GPT-2於2019年發佈。[11]2020年又再次擴大規模發佈了擁有1750億個參數的GPT-3。[1]

DALL-E模型是GPT-3的多模態實現,共擁有120億個參數[1],使用從網絡上收集的文本和圖像對進行訓練。 [7]它使用零樣本學習從描述和提示中生成輸出,而無需進一步訓練。[12]

DALL-E會根據提示生成多個圖像,之後由CLIP模型對這些圖像進行排序。[2]CLIP模型使用了超過4億對圖像和文本進行訓練。[1]該模型是一個圖像識別系統[13],它的訓練集是從網絡上抓取的圖像與描述,而不是諸如ImageNet之類的經過整理的標記圖像數據集。[7]CLIP將圖像與所有文本相關聯。[7]它能夠預測哪個文本(從32768個隨機採樣的文本中選擇)最適合圖像,使其在之後有能力識別不在其訓練集之中的圖像中的對象。 [7]

表現

[編輯]DALL-E能夠生成各種風格的圖像,從照相寫實主義圖像[1]到繪畫和表情符號。它還可以「操縱和重新排列」圖像中的對象。[1]其創作者指出DALL-E的一項能力是在沒有明確指示的情況下將設計元素正確放置在新穎的作品中:「例如,當被要求畫一個白蘿蔔擤鼻涕、喝拿鐵或騎獨輪車時,DALL-E通常能在合理的位置畫出手帕、手和腳。」 [14]

DALL-E展現了多種能力。《Input》[15]、NBC[16]、《自然》[17]等的報道文章中都提到了DALL-E生成的「穿着芭蕾舞裙遛狗的小白蘿蔔插圖」。 [1][18][19]而它生成的「鱷梨形狀的扶手椅」也同樣受到關注。[7][20]另一方面,DALL-E還展現出了足以解決瑞文氏標準推理測驗(通常用於測量人類智力的視覺測試)的視覺推理技能。 [21]

另外透過增加API提示,可以生成符合特定用途或風格的圖片,用以中性化或達成特殊目的。例如文字與圖片相互配合的語言遲緩治療工具[22],因為對象多為學齡前幼兒,所以必須將圖片濾除太過成人導向的部分。。

劍橋大學機器學習教授尼爾·勞倫斯(Neil Lawrence)認為DALL-E這類模型有能力存儲關於我們這個世界的信息,並以人類認為非常自然的方式進行推廣。佐治亞理工學院交互計算學院副教授馬克·里德爾(Mark Riedl)則認為DALL-E的演示結果表明它能夠協調地融合概念,這是人類創造力的關鍵要素,同時他指出DALL-E繪製的插圖比過去幾年其他的Text2Image(由文本生成圖像)系統要出色許多。[23]

DALL-E模型在沒有特定提示的情況下也能夠推斷合適細節的能力也受到了關注。技術博客ExtremeTech注意到,DALL-E繪製的「穿着聖誕毛衣的企鵝」不僅會生成企鵝穿着毛衣的圖像,而且還會生成與主題相關的聖誕老人帽。[24]另一個技術博客Engadget則注意到模型生成的「一幅一隻狐狸冬天坐在田野里的畫」中出現了適當放置的陰影。[12]此外,DALL-E展示了對視覺和設計趨勢的廣泛理解。例如,DALL-E可以繪製指定年代的手機或吸塵器的照片,它了解這些物體的形態是如何隨時間改變的。[24][12]

不過有時模型也會出現錯誤。比如DALL-E 2就無法區分「一本黃色的書與一個紅色的花瓶」與「一本紅色的書與一個黃色的花瓶」這兩個描述,也無法區分「正在咖啡拉花的熊貓」與「熊貓圖案的咖啡拉花」。[25]

參見

[編輯]參考文獻

[編輯]- ^ 1.0 1.1 1.2 1.3 1.4 1.5 1.6 1.7 1.8 Johnson, Khari. OpenAI debuts DALL-E for generating images from text. VentureBeat. 2021-01-05 [2021-01-05]. (原始內容存檔於2021-01-05).

- ^ 2.0 2.1 2.2 2.3 2.4 2.5 Coldewey, Devin. OpenAI's DALL-E creates plausible images of literally anything you ask it to. 2021-01-05 [2021-01-05]. (原始內容存檔於2021-01-06).

- ^ Grossman, Gary. OpenAI's text-to-image engine, DALL-E, is a powerful visual idea generator. VentureBeat. 2021-01-16 [2021-03-02]. (原始內容存檔於2021-02-26).

- ^ Andrei, Mihai. This AI module can create stunning images out of any text input. ZME Science. 2021-01-08 [2021-03-02]. (原始內容存檔於2021-01-29).

- ^ Walsh, Bryan. A new AI model draws images from text. Axios. 2021-01-05 [2021-03-02]. (原始內容存檔於2021-11-25).

- ^ Dayma, Boris; Patil, Suraj; Cuenca, Pedro; Saifullah, Khalid; Abraham, Tanishq; Lê Khắc, Phúc; Melas, Luke; Ghosh, Ritobrata, DALL·E Mini, 2021 [2021-11-29], doi:10.5281/zenodo.5146400, (原始內容存檔於2022-08-05)

- ^ 7.0 7.1 7.2 7.3 7.4 7.5 7.6 7.7 7.8 Heaven, Will Douglas. This avocado armchair could be the future of AI. MIT Technology Review. 2021-01-05 [2021-01-05]. (原始內容存檔於2021-01-05).

- ^ KAHN, JEREMY. Move over Photoshop: OpenAI has just revolutionized digital image making. Fortune. 2022-04-06 [2022-04-10]. (原始內容存檔於2022-04-10) (英語).

- ^ DALL·E 2. OpenAI. [2022-04-06]. (原始內容存檔於2022-04-06) (英語).

- ^ Radford, Alec. Improving Language Understanding by Generative Pre-Training (PDF). OpenAI: 12. 2018-06-11 [2021-01-23]. (原始內容 (PDF)存檔於2021-01-26).

- ^ Radford, Alec; Wu, Jeffrey; Child, Rewon; Luan, David; Amodei, Dario; Sutskever, Ilua. Language models are unsupervised multitask learners (PDF) 1 (8). 2019-02-14 [2020-12-19]. (原始內容存檔 (PDF)於2021-02-06).

- ^ 12.0 12.1 12.2 Dent, Steve. OpenAI's DALL-E app generates images from just a description. Engadget. 2021-01-06 [2021-03-02]. (原始內容存檔於2021-01-27).

- ^ For Its Latest Trick, OpenAI's GPT-3 Generates Images From Text Captions. Synced. 2021-01-05 [2021-03-02]. (原始內容存檔於2021-01-06).

- ^ Dunn, Thom. This AI neural network transforms text captions into art, like a jellyfish Pikachu. BoingBoing. 2021-02-10 [2021-03-02]. (原始內容存檔於2021-02-22).

- ^ Kasana, Mehreen. This AI turns text into surreal, suggestion-driven art. Input. 2021-01-07 [2021-03-02]. (原始內容存檔於2021-01-29).

- ^ Ehrenkranz, Melanie. Here's DALL-E: An algorithm learned to draw anything you tell it. NBC News. 2021-01-27 [2021-03-02]. (原始內容存檔於2021-02-20).

- ^ Stove, Emma. Tardigrade circus and a tree of life — January's best science images. Nature. 2021-02-05 [2021-03-02]. (原始內容存檔於2021-03-08).

- ^ Knight, Will. This AI Could Go From 'Art' to Steering a Self-Driving Car. Wired. 2021-01-26 [2021-03-02]. (原始內容存檔於2021-02-21).

- ^ Metz, Rachel. A radish in a tutu walking a dog? This AI can draw it really well. CNN. 2021-02-02 [2021-03-02]. (原始內容存檔於2022-07-16).

- ^ Wakefield, Jane. AI draws dog-walking baby radish in a tutu. British Broadcasting Corporation. 2021-01-06 [2021-03-03]. (原始內容存檔於2021-03-02).

- ^ Markowitz, Dale. Here's how OpenAI's magical DALL-E image generator works. TheNextWeb. 2021-01-10 [2021-03-02]. (原始內容存檔於2021-02-23).

- ^ 小秋子繪本. 小秋子繪本. 小秋子繪本.

- ^ Shead, Sam. Why everyone is talking about an image generator released by an Elon Musk-backed A.I. lab. CNBC. 2021-01-08 [2021-03-02]. (原始內容存檔於2022-07-16).

- ^ 24.0 24.1 Whitwam, Ryan. OpenAI's 'DALL-E' Generates Images From Text Descriptions. ExtremeTech. 2021-01-06 [2021-03-02]. (原始內容存檔於2021-01-28).

- ^ Saharia. Photorealistic Text-to-Image Diffusion Models with Deep Language Understanding. arXiv:2205.11487

.

.

| |||||||||||||||

| ||||||||||||||||||||||||||||