高頻寬記憶體

高頻寬記憶體(英語:High Bandwidth Memory,縮寫HBM),是三星電子、超微半導體和SK海力士發起的一種基於3D堆疊工藝的高效能DRAM,適用於高記憶體頻寬需求的應用場合,與高效能圖形處理器、網路交換及轉發裝置(如路由器、交換器)、高效能資料中心的AI特殊應用積體電路結合使用,在 CPU 中用作包內高速緩衝記憶體,在即將推出的 CPU 和 FPGA 中用作包內 RAM,還用於某些超級電腦(如 NEC SX-Aurora TSUBASA 和富士通 A64FX)。[1][2]首款HBM主記憶體晶片由SK海力士於2013年生產,[3]首款使用高頻寬記憶體的裝置是AMD Radeon Fury系列顯示核心[4][5]。

2013年10月,高頻寬記憶體正式被JEDEC採納為業界標準。[6]第二代高頻寬記憶體(HBM2)於2016年1月被JEDEC採納。[7]NVIDIA在該年發表的新款旗艦型Tesla運算加速卡 —— Tesla P100、AMD的Radeon RX Vega系列、Intel的Knight Landing也採用了第二代高頻寬記憶體。

技術細節

[編輯]相比較DDR4或GDDR5而言,高頻寬記憶體以更小的體積、更少的功率達到更高的頻寬。[8]通過堆疊多達八個DRAM晶片裸晶(即三維積體電路)和一個可選的基本晶片(包括緩衝電路和測試邏輯)來實現。[9]堆疊通常通過基板連接到 GPU 或 CPU 上的主記憶體控制器。另外,記憶體晶片也可以直接堆疊在CPU或GPU晶片上。[10][11]堆疊內,晶片通過矽穿孔(TSV)及微突起相連接的可選基底裸晶,附帶主記憶體控制器。高頻寬記憶體技術原理上與美光科技開發的混合主記憶體立方體介面類似,但不相容。[12][13]

高頻寬記憶體主記憶體匯流排與其他DRAM主記憶體(如DDR4或GDDR5)相比更加寬闊。在擁有四塊DRAM裸晶的高頻寬記憶體堆(4-Hi)上,每個裸晶均有兩條128位元的信道,四塊加起來總共有八條。搭載四塊4-Hi高頻寬記憶體堆的圖形卡(GPU)將擁有4096位元寬的主記憶體匯流排。做個比較,GDDR主記憶體給圖形顯示卡的信道寬度為32位元,其主記憶體介面則為512位元。[14]高頻寬記憶體最高支援每個封裝4GB的主記憶體。

相比較DDR4或GDDR5而言,主記憶體的最大連接數越多,高頻寬記憶體就需要以更新的方法連接至圖形處理器(或其他處理器)。[15]AMD和輝達均使用為特定目的打造的矽片——中介層,來連接主記憶體及圖形處理器。中介層需要將主記憶體與處理器放置在相鄰的位置,以減短主記憶體路徑。但由於半導體器件製造的製造費用比印刷電路板的高出不少,客戶也需花費更多金錢購買此類產品。

-

HBM DRAM晶片

-

HBM控制器晶片

-

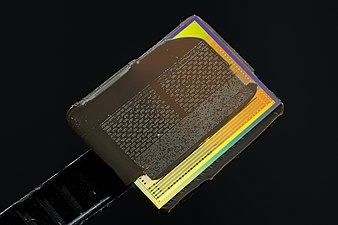

AMD Radeon R9 Nano顯示卡GPU包上的HBM主記憶體

介面

[編輯]高頻寬記憶體DRAM需要將宿主計算裸晶與分為多個獨立信道的分散式介面緊密結合起來。這些信道相互之間完全獨立,且不一定同步。高頻寬記憶體DRAM使用寬介面架構來執行高速、節能的計算操作。高頻寬記憶體DRAM使用500 MHz的差分時鐘 CK_t / CK_c(字首「_t」表示「真」(True)、「正值」(Positvie)及差分對組件(Components of differential pair),「_c」則代表「互補」部分(Complementary))。指令在CK_t和CK_c的訊號上升沿註冊。每個信道以雙資料速率(DDR)管理128位元的資料匯流排。高頻寬記憶體支援每針1 GT/s(1位元)的傳輸速率,總體封裝頻寬則能達到128 GB/s。[16]

HBM2

[編輯]第二代高頻寬記憶體(HBM2)指定了每堆8個裸晶及每訊框傳輸速度上至2 GT/s的標準。為保持1024位元寬的訪問,第二代高頻寬記憶體得以在每個封裝中達到256GB/s的主記憶體頻寬及上至8GB的主記憶體。業界預測第二代HBM在極其需要效能的應用程式(如虛擬實境)中至關重要。[17]

2016年1月19日,三星集團宣布進入大量生產第二代高頻寬記憶體的早期階段,每堆擁有高達8GB的主記憶體。[18][19]SK海力士同時宣布於2016年8月發布4GB版本的主記憶體。[20]

-

HBM2 DRAM晶片

-

HBM2控制器晶片

-

Radeon RX Vega 64 GPU的HBM2中介層,已移除HBM晶片;GPU仍在原位

HBM2E

[編輯]2018年下半年,JEDEC宣布升級第二代HBM標準,提升頻寬及其能力。[21]官方標準中明確每堆最高307GB/s(有效資料速率則為2.4Tbit/s),但就實際而言,市面上已早有以此速度執行的產品。除此之外,標準還添加了對12-Hi堆的支援,使每堆24GB的主記憶體成為可能。

2019年3月20日,三星發布了Flashbolt HBM2E,每個堆疊有8個晶片,傳輸速率為3.2 GT/s,每個堆疊總共提供16 GB和410 GB/s。[22]8月12日,SK海力士宣布推出HBM2E,每個堆疊有8個晶片,傳輸速率為3.6 GT/s,每個堆疊總共提供16 GB和460 GB/s,[23][24]2020年7月2日,宣布開始量產。[25]

HBM3

[編輯]第三代高頻寬記憶體(HBM3)於2016年正式發布,[26][27]此代標準擴大了主記憶體容量、提升了主記憶體頻寬(512GB/s或更高)並降低了電壓與價格。人們猜測高頻寬記憶體的密度增加是因為裸晶數量及其密度的增加導致。業界尚未宣布正式發布日期。三星專家預測在2020年前進行第三代高頻寬記憶體的量產。據南韓《中央日報》報導,SK 海力士 (000660-KR) 2021年10月20日宣布,該公司已研發出當前規格最高的高頻寬記憶體「HBM3」,在2020年7月的時候,海力士也領先業界推出「HBM2」的擴張版本「HBM2E」。

HBM4

[編輯]為了打造能進行百億億次計算的高效能電腦,慧與科技預測OPGHC HBM3+及HBM4將在2022年至2024年間發布。更為強大的堆疊能力及更高的物理密度理論上應能讓每塊插槽的可定址主記憶體及執行速度更上一層樓。HBM3+的計劃速度為4 TB/s,每塊插槽的計劃可定址主記憶體(做個類比,AMD的高端EPYC晶片在每個插槽上可以150GB/s的速度定址)。[28]有了32 Gbit(4 GB)的DRAM裸晶,再加上HBM3+每堆上的16片裸晶,每個HBM3+組件理論上能提供64GB的容量。

歷史

[編輯]

早在2008年,AMD就開始著手研發高頻寬記憶體來解決日益增長的能源使用及電腦主記憶體的形狀因數。其中,AMD進階研究員布賴恩·布萊克(Bryan Black)解決了裸晶堆疊問題。AMD還從主記憶體行業(SK海力士)、插入器行業(聯華電子)及封裝行業(日月光半導體)的合作夥伴中獲得了幫助,讓高頻寬記憶體從設想變成現實。[29]2015年,SK海力士在韓國利川市的工廠正式開始量產。

在2010年AMD與SK海力士共同發表提案後的2013年10月,高頻寬記憶體被JEDEC設立為業界標準(JESD235)。[6]首款使用高頻寬記憶體的裝置是AMD Radeon Fury系列顯示核心,其驅動了AMD Radeon R9 Fury X。[30][4][31]

第二代高頻寬記憶體則於2016年1月被JEDEC認可為業界標準(JESD235a)。[7]首款使用第二代高頻寬記憶體技術的圖形處理器是於2016年4月發布的輝達 Tesla P100。[32][33]

未來

[編輯]在2016年8月的熱門晶片上,三星與海力士均宣布了下一代高頻寬記憶體技術。[34][35]兩家公司都預計下一代產品的裸晶密度、頻寬得到提升,同時減少能源消耗。三星還宣布將發布低成本版本的高頻寬記憶體,此類產品將移除快取裸晶、減少矽穿孔,並將總頻寬降至200GB/s。

另請參閱

[編輯]參考文獻

[編輯]- ^ Shilov, Anton. Intel Confirms On-Package HBM Memory Support for Sapphire Rapids. Tom's Hardware. December 30, 2020 [January 1, 2021] (美國英語).

- ^ ISSCC 2014 Trends 網際網路檔案館的存檔,存檔日期2015-02-06. page 118 "High-Bandwidth DRAM"

- ^ History: 2010s. SK Hynix. [7 March 2023].

- ^ 4.0 4.1 Smith, Ryan. The AMD Radeon R9 Fury X Review. Anandtech. 2015-07-02 [2016-08-01]. (原始內容存檔於2016-07-22).

- ^ Morgan, Timothy Prickett. Future Nvidia ‘Pascal’ GPUs Pack 3D Memory, Homegrown Interconnect. EnterpriseTech. 2014-03-25 [2014-08-26]. (原始內容存檔於2014-08-26).

Nvidia will be adopting the High Bandwidth Memory (HBM) variant of stacked DRAM that was developed by AMD and Hynix

- ^ 6.0 6.1 High Bandwidth Memory (HBM) DRAM (JESD235) (頁面存檔備份,存於網際網路檔案館), JEDEC, October 2013

- ^ 7.0 7.1 JESD235a: High Bandwidth Memory 2. 2016-01-12 [2017-06-04]. (原始內容存檔於2019-06-07).

- ^ HBM: Memory Solution for Bandwidth-Hungry Processors 網際網路檔案館的存檔,存檔日期2015-04-24., Joonyoung Kim and Younsu Kim, SK Hynix // Hot Chips 26, August 2014

- ^ Sohn et.al. (Samsung). A 1.2 V 20 nm 307 GB/s HBM DRAM With At-Speed Wafer-Level IO Test Scheme and Adaptive Refresh Considering Temperature Distribution. IEEE Journal of Solid-State Circuits. January 2017, 52 (1): 250–260. Bibcode:2017IJSSC..52..250S. S2CID 207783774. doi:10.1109/JSSC.2016.2602221.

- ^ What's Next for High Bandwidth Memory. 17 December 2019.

- ^ Interposers.

- ^ Where Are DRAM Interfaces Headed? 網際網路檔案館的存檔,存檔日期2018-06-15. // EETimes, 4/18/2014 "The Hybrid Memory Cube (HMC) and a competing technology called High-Bandwidth Memory (HBM) are aimed at computing and networking applications. These approaches stack multiple DRAM chips atop a logic chip."

- ^ Where Are DRAM Interfaces Headed? (頁面存檔備份,存於網際網路檔案館) // EETimes, 4/18/2014 "The Hybrid Memory Cube (HMC) and a competing technology called High-Bandwidth Memory (HBM) are aimed at computing and networking applications. These approaches stack multiple DRAM chips atop a logic chip."

- ^ Highlights of the HighBandwidth Memory (HBM) Standard (頁面存檔備份,存於網際網路檔案館). Mike O』Connor, Sr. Research Scientist, NVidia // The Memory Forum – June 14, 2014

- ^ Smith, Ryan. AMD Dives Deep On High Bandwidth Memory – What Will HBM Bring to AMD?. Anandtech. 2015-05-19 [2017-05-12]. (原始內容存檔於2017-05-05).

- ^ High-Bandwidth Memory (HBM) (PDF). AMD. 2015-01-01 [2016-08-10]. (原始內容存檔 (PDF)於2019-03-18).

- ^ Valich, Theo. NVIDIA Unveils Pascal GPU: 16GB of memory, 1TB/s Bandwidth. VR World. [2016-01-24]. (原始內容存檔於2019-07-14).

- ^ Samsung Begins Mass Producing World’s Fastest DRAM – Based on Newest High Bandwidth Memory (HBM) Interface. news.samsung.com. [2019-07-08]. (原始內容存檔於2019-06-21).

- ^ Samsung announces mass production of next-generation HBM2 memory – ExtremeTech. 2016-01-19 [2019-07-08]. (原始內容存檔於2019-07-14).

- ^ Shilov, Anton. SK Hynix Adds HBM2 to Catalog. Anandtech. 2016-08-01 [2016-08-01]. (原始內容存檔於2016-08-02).

- ^ JEDEC Updates Groundbreaking High Bandwidth Memory (HBM) Standard (新聞稿). JEDEC. 2018-12-17 [2018-12-18]. (原始內容存檔於2018-12-18).

- ^ Samsung Electronics Introduces New High Bandwidth Memory Technology Tailored to Data Centers, Graphic Applications, and AI | Samsung Semiconductor Global Website. www.samsung.com. [2019-08-22] (英語).

- ^ SK Hynix Develops World's Fastest High Bandwidth Memory, HBM2E. www.skhynix.com. August 12, 2019 [2019-08-22].

- ^ SK Hynix Announces its HBM2E Memory Products, 460 GB/S and 16GB per Stack.

- ^ SK hynix Starts Mass-Production of High-Speed DRAM, "HBM2E". 2 July 2020.

- ^ Walton, Mark. HBM3: Cheaper, up to 64GB on-package, and terabytes-per-second bandwidth. Ars Technica. 2016-08-23 [2017-02-03]. (原始內容存檔於2017-02-02).

- ^ Ferriera, Bruno. HBM3 and GDDR6 emerge fresh from the oven of Hot Chips. Tech Report. 2016-08-23 [2017-02-03]. (原始內容存檔於2017-02-04).

- ^ 存档副本. [2019-07-08]. (原始內容存檔於2019-04-01).

- ^ [1] (頁面存檔備份,存於網際網路檔案館) High-Bandwidth Memory (HBM) from AMD: Making Beautiful Memory

- ^ Smith, Ryan. AMD HBM Deep Dive. Anandtech. 2015-05-19 [2016-08-01]. (原始內容存檔於2016-08-11).

- ^ [2] (頁面存檔備份,存於網際網路檔案館) AMD Ushers in a New Era of PC Gaming including World’s First Graphics Family with Revolutionary HBM Technology

- ^ Smith, Ryan. Nvidia announces Tesla P100 Accelerator. Anandtech. 2016-04-05 [2016-08-01]. (原始內容存檔於2016-07-30).

- ^ NVIDIA Tesla P100: The Most Advanced Data Center GPU Ever Built. www.nvidia.com. [2019-07-08]. (原始內容存檔於2018-05-13).

- ^ Smith, Ryan. Hot Chips 2016: Memory Vendors Discuss Ideas for Future Memory Tech – DDR5, Cheap HBM & More. Anandtech. 2016-08-23 [2016-08-23]. (原始內容存檔於2016-08-24).

- ^ Walton, Mark. HBM3: Cheaper, up to 64GB on-package, and terabytes-per-second bandwidth. Ars Technica. 2016-08-23 [2016-08-23]. (原始內容存檔於2016-08-23).

外部連結

[編輯]- High Bandwidth Memory (HBM) DRAM (JESD235) (頁面存檔備份,存於網際網路檔案館), JEDEC, October 2013

- Lee, Dong Uk; Kim, Kyung Whan; Kim, Kwan Weon; Kim, Hongjung; Kim, Ju Young; et al. A 1.2V 8Gb 8‑channel 128GB/s high-bandwidth memory (HBM) stacked DRAM with effective microbump I/O test methods using 29nm process and TSV. 2014 IEEE International Solid-State Circuits Conference – Digest of Technical Papers (IEEE). 9–13 Feb 2014: 432–433 (6 March 2014) [2019-04-13]. doi:10.1109/ISSCC.2014.6757501.

- HBM vs HBM2 vs GDDR5 vs GDDR5X Memory Comparison (頁面存檔備份,存於網際網路檔案館)