人工智能哲學

| 人工智能系列內容 |

|---|

人工智能哲學是心智哲學和計算機科學的哲學的一個分支,[1]探討人工智能以及對知識、智力、倫理、意識、認識論和自由意志的理解。[2][3]此外,這項技術涉及創造人造動物或人造人(或至少是人造生物;參見人工生命),因此哲學家對這門學科相當感興趣。[4]這些因素促成了人工智能哲學的出現。

人工智能哲學試圖回答下列問題[5]:

這三個問題分別反映了人工智能開發者、語言學家、認知科學家和哲學家的不同興趣。透過討論 「智能」、「意識」的定義,和「機械」究竟是什麼,來尋找這些問題的科學答案。

人工智能哲學的重要主張包括:

- 圖靈的禮貌公約:如果一個機器的行為可以如人類一般,那麼它就和人類擁有同樣的智能。[6]

- 達特茅斯提議:「如果可以精確的描述學習的所有面向,或智能的任何其它特徵,一個機器就可以被製造來模擬它。」[7]

- 紐厄爾和司馬賀的物理符號系統假設:「物理符號系統具有執行一般智能動作必要的和充分的手段。」[8]

- 塞爾強人工智能假設:「只要電腦有適當的程式讓能夠正確的輸入和輸出,就能擁有與人類精神相同意義的精神。」[9]

- 霍布斯機制:「理性只是計算。」[10]

機器能顯示一般智能嗎?

[編輯]有沒有可能創造出一種能用人類智能解決所有問題的機器?這個問題指示了機器能力的範圍,指引着人工智能研究的方向。它只涉及機器的行為,而忽略了心理學、認知科學和哲學感興趣的問題,從而引發了這樣一個問題:機器是否真的像人一樣在思考,而非只是看上去在思考?這重要嗎?[11]

大多數AI研究者的基本立場可以用達特茅斯會議(1956)上的這句話概括:

- 「學習的所有方面,及智能的所有特徵,原則上都可以得到精確的描述,且可以製造一台機器來模擬。」[7]

反對這一基本前提的論點要說明,受限於計算機的實際能力,或者由於人類思維的某種智能行為必須的特殊品質,使得機器(或目前的人工智能研究方法)不可能複製人類智能,於是也不可能建立一個有效的人工智能系統。支持這一基本前提的論證要說明,這種系統是可能存在的。

當然,也可以迴避上述兩論點之間的聯繫。例如,圖靈的兒童機假設[12]基本上就實現了所需的智能特徵,卻不需要精確的設計具體運作的方法。關於機械人隱性知識[13]的論述更是完全不需要精確描述。

要回答這個問題,首先要定義什麼是「智能」。

智能

[編輯]

圖靈測試

[編輯]阿蘭·圖靈[15]將智能的定義簡化為簡單的對話問題:若一台機器能用普通人會說的話回答向它提出的任何問題,就可以稱這台機器有智能。這個設計的現代版本是一個在線聊天室,兩個參與者是人類與程序。如果沒有人能分辨出兩個參與者中誰是人類,那麼這個程序就通過了測試。[6]圖靈指出,從沒有人(哲學家除外)提出過「人會思考嗎」這個問題:「與其在這一點上爭論不休,不如約定俗成地認為每個人都會思考。」[16]圖靈測試將這一習慣延伸到了機器上:

- 如果一台機器的行為和人類一樣智能,那麼它就和人類一樣智能。

對圖靈測試的一種批評是,它只能測量機器行為的「人性化」程度,而非行為的「智能」程度:人類行為和智能行為並不完全相同,因此該測試無法衡量智能。Stuart J. Russell和彼得·諾維格寫道:「航空工程學的教科書並沒有將領域目標定義為『製造能像鴿子一樣準確飛行的機器,直到能騙過鴿子。』」[17]

實現目標的智能

[編輯]

21世紀的AI研究將智能定義為以目標為導向的行為,將智能視為機器要解決的一系列問題——能解決的問題越多,解決得越好,程序就越智能。「人工智能」概念的提出者約翰·麥卡錫將智能定義為「在世界上實現目標的能力的計算部分」。[18]

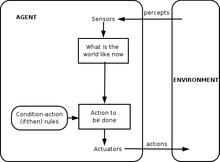

Stuart J. Russell和彼得·諾維格利用抽象的智能體形式化了這一概念。「智能體」是能在環境中感知並行動的事物,「性能度量」則描述了智能體的智能程度。[19]

- 「智能體的行為是使基於過去經驗和知識的性能度量預期值最大化。」[20]

類似這樣的定義試圖抓住智能的本質,優點是不會囊括人類的非智力特徵,如打字錯誤;[21]缺點是無法區分事物「會不會思考」 :根據這個定義,恆溫容器也具有初級智能。[22]

關於機器可以展示一般智能的論點

[編輯]大腦可以被模擬

[編輯]Hubert Dreyfus將這一論點描述為:「如果神經系統遵守物理、化學定律(完全有理由認為其完全遵守),則......應該可以用某種物理裝置重現神經系統的行為。」[23][24](1943)首次提出之,漢斯·莫拉維克(1988)對其進行了生動描述。[25]目前,未來學家雷蒙德·庫茨魏爾將其與大腦模擬聯繫在一起,他估計到2029年,計算機將有足夠的算力進行完整的大腦模擬。 [26]2005年,出現了丘腦皮質模型的非實時模擬,模型大小相當於人腦(1011個神經元),[27]在個由27個處理器組成的集群上模擬1秒鐘的大腦動態需要50天。

即使是AI最嚴厲的批評者(如Hubert Dreyfus和約翰·瑟爾)也同意,大腦模擬在理論上是可能的。[a] 然而,瑟爾也指出:原則上任何東西都可以被計算機模擬,因此把這定義無限推下去,就會得到:嚴格來說,任何過程都能視作是「計算」。「我們想知道的是,思維與恆溫容器和肝臟的區別在哪裏。」[30]因此,僅僅模擬活體大腦的運,作就等於承認自己對智能與思維本質的無知,就像是在不了解任何航空航天工程理論時,通過一根羽毛一根羽毛地精確複製一隻鳥來製造飛機一樣。[31]

人類思維是符號加工

[編輯]1963年,艾倫·紐厄爾和司馬賀提出,「符號加工」是人類和機器智能的本質。他們寫道:

- 「物理符號系統具有一般智能行動的充分與必要手段。」[8]

這種說法非常有力,意味着人類思維是一種符號操縱(符號系統是智能的必要條件),也意味着機器可以是智能的(符號系統足以構成智能)。[32] 哲學家Hubert Dreyfus描述了這種立場的另一個版本,他稱之為「心理假設」:

- 「心智可以視作按形式規則對比特信息進行操作的裝置。」[33]

紐厄爾、西蒙和Dreyfus討論的「符號」是類似於詞語的高級符號,直接與現實物體相對應,如<狗>、<尾巴>之類。1956直至1990年間出現的大多數人工智能程序都使用這種符號。基於統計與數學優化的現代人工智能已經脫離了這一層次。

反對符號加工的論點

[編輯]這些論點表明,人類思維不(僅)是由高層次符號加工組成。這不是說人工智能是不可能的,只是指出在符號加工之外還需要別的要素。

哥德爾反機械論

[編輯]1931年,庫爾特·哥德爾證明了哥德爾不完備定理:總可以構造出「哥德爾算式」使給定的一致形式系統(如高級符號作業系統)無法證明之。雖然構造的哥德爾算式是真語句,但在給定系統內卻是無法證明的(哥德爾算式的真假取決於給定系統的一致性;對微妙地不一致系統應用同樣的過程看似可行,但實際上會產出錯誤的「哥德爾算式」)。[來源請求]更推測性地說,哥德爾猜想,人類思維最終可以正確判斷任何有根據的數學語句(包括所有哥德爾算式)的真假,因此人類思維不能還原為一種機械。[34]哲學家John Lucas (1961起)和羅傑·彭羅斯(1989起)一直倡導這種哲學上的反機械論。[35]

哥德爾反機械論的論證往往依賴於一個看似無關緊要的主張,即所謂人類數學家系統(或人類數學家的某種理想化)一致(沒有錯誤)且完全相信自身的一致性(並能做出從自身一致性出發的推理,包括相信其哥德爾算式)[來源請求]。圖靈機因停機問題不可能做到這一點,因此哥德爾主義者得出結論:人類的推理能力強得無法被圖靈機捕捉,推而廣之,也無法被任何數字機械設備捕捉。

然而,科學界和數學界的現代共識是,實際的人類推理是不一致的;任何一致的「理想化」人類推理H在邏輯上都會被迫地開放式懷疑自身的一致性(否則H就可證明不一致);這不滿足哥德爾不完備定理的條件,也就無法得到「人類具有機器無法複製的數學推理能力」。[36][37][38]關於哥德爾反機械論註定要失敗的共識在《人工智能》期刊中得到了有力闡述:「任何試圖(用哥德爾不完備定理)攻擊計算主義都註定的,都是非法(invalid)、無效的,因為這些結果實際上與計算主義完全一致。」[39]

Stuart Russell和彼得·諾維格同意,哥德爾主義論證沒有考慮現實世界中人類推理的本質。它適用於在內存和時間無限的情況下理論上可以證明的問題。實際上,真實機器(包括人類)的資源是有限的,很難證明許多定理。要成為一個有智能的人,並不一定要能證明一切。[40]

侯世達在獲得了普立茲獎的圖書《集異璧》中指出,這些「哥德爾算式」總是指系統本身,與說謊者悖論使用「這句話是謊話」之類自指語句進行類比。[41]不過當然,說謊者悖論適用於任何有算式的事物,無論是機器還是人類,甚至自身。考慮:

- John Lucas無法斷定這句話的真實性。[42]

這一說法是正確的,但John Lucas卻無法斷言。這表明,John Lucas本人和所有人一樣,都受到他描述的機器的限制,因此他的論證毫無意義。[43]

彭羅斯得出人類推理不可能通過計算實現後,繼續推測:某種涉及量子力學狀態坍縮的不可計算過程,使人類比計算機具有獨特的優勢。現有的量子計算機只能降低圖靈可計算任務的複雜性,仍局限於圖靈機可處理的任務。根據彭羅斯和盧卡斯的論點,這一事實意味着它們不足以模擬人類思維。[來源請求][需要解釋]。因此,彭羅斯尋求其他一些涉及新物理學的過程,例如量子引力,可能通過波函數的自發量子坍縮,在普朗克質量的尺度上表現出新的物理學。他認為,這些過程可能發生在神經元內部,也可能跨越多個神經元。[44]然而,其他科學家指出,大腦中不存在利用任何量子計算的可信有機機制;此外,量子退相干的時間尺度太狹窄,無法影響神經元的激活過程。[45]

Dreyfus:隱藏技能的首要性

[編輯]Hubert Dreyfus認為,人類智能主要依賴於快速的直覺判斷,而不是逐步的符號操作,並認為這些技能永遠無法精確表達為形式化的規則。[46]

Dreyfus的論點早在圖靈的《計算機器與智能》(1950)論文中就有所預見,他將其歸類為「行為非形式性觀點」。[47]對此,圖靈認為,我們並不知道支配複雜行為的規則(也許存在)。他寫道:「我們不能輕易說服自己不存在完整的行為法則……我們所知,發現這種法則的唯一途徑是科學觀察。我們當然知道,在任何情況下都不能說『已經找遍了,沒有這樣的法則。』」[48]

羅素和諾維格指出,自Dreyfus發表評論以來,人們在發現無意識推理的「規則」方面取得了進展。[49]機械人學研究中的「情境運動」(situated movement)試圖捕捉我們在感知和注意力方面的無意識技能。[50]神經網絡、進化算法之類的計算智能範式主要面向模擬無意識。人工智能的統計方法可以做出接近人類直覺猜測的預測。對常識性知識的研究側重於再現知識的「背景」。事實上,人工智能研究總體上已經從高層次符號操作轉向捕捉直覺推理的新模型。[49]

認知科學和心理學最終同意Dreyfu對人類專長的描述。丹尼爾·卡尼曼等人也提出了類似理論,確定了人類用來解決問題的兩個「系統」,可稱之為「直覺系統」(快速直覺判斷)和「逐步系統」(較慢逐步思考)。[51]

雖然Dreyfus的觀點在許多方面得到了重信任,但認知科學和人工智能領域的工作針對具體問題展開,並沒有受到Dreyfus的直接影響。歷史學家和人工智能研究者Daniel Crevier寫道:「時間證明了Dreyfus某些觀點的準確性與敏銳性,如果他不那麼咄咄逼人,那些建議可能會更早得到應有的重視。」[52]

機器能有思想、意識與心理狀態嗎?

[編輯]這是一個哲學問題,與他心問題和困難問題有關。這個問題圍繞着約翰·瑟爾定義為「強人工智能」的立場展開:

- 物理符號系統可以有意識和心理狀態。[9]

瑟爾將這一立場與所謂「弱人工智能」區分開來:

- 物理符號系統可以智能地行動。[9]

瑟爾引入這些術語是為了區分強弱AI,這樣就能專注於他關注的問題。他認為,即使假定存在與人類思維一模一樣的行為的電腦程式,也仍有棘手的哲學問題需要回答.[9]

瑟爾的這兩個立場都不是人工智能研究的重點,因為它們並沒有直接回答「機器能否顯示出一般智能」的問題(除非也能證明意識是智能的必要條件)。圖靈寫道:「我不想給人留下這樣的印象:我認為意識並不神秘……[但]我並不認為在我們能回答[機器能否思考]這個問題之前,這些謎團就一定需要解開。」[53]Russell和諾維格對此表示贊同:「大多數人工智能研究人員認為弱AI假說是理所應當的,卻不關心強AI假說。」[54]

有一些研究者認為,意識是智能的基本要素,如Igor Aleksander、Stan Franklin、Ron Sun、Pentti Haikonen等人,不過他們對「意識」的定義與「智能」非常接近(見人工意識)。

在回答這個問題之前,必須明確「心智」(mind)「心理狀態」(mental state)「意識」(consciousness)的含義。

意識、心智與心理狀態的含義

[編輯]不同群體對「心智」(mind)和「意識」(consciousness)這兩個詞有不同用法。例如,一些新紀元運動思想家用「意識」描述與亨利·柏格森所謂「生命衝力」之類的事物:一種無形的、充滿活力的流體,滲透到生命中,尤其是心智中。科幻作品則用這個詞描述人類的某些本質屬性:具有「意識」的機器或外星人會被描繪為人類形態的角色,擁有智慧、欲望、意志、洞察力、自豪感等等。(科幻作家也用「感知能力」(sentience)「智慧」(sapience)「自覺」(self-awareness)乃至「鬼」,如《攻殼機動隊》,以描述這種本質人類屬性)。對其他人[誰?]來說,「心智」「意識」之類是靈魂的世俗化同義詞。

對哲學家、神經科學家、認知科學家來說,這些詞的使用更精確也更世俗:它們指我們熟悉的「腦海中有個主意」的日常體驗,如感知、夢想、意圖與計劃,以及看到某物、知道某物、理解某物的方式等等。[55]哲學家瑟爾認為「給意識下個常識性定義並不難。」[56]意識的神秘和迷人之處不在於它是什麼,而在於形成過程:一團脂肪組織和小小的電流是如何產生這種感知、意義與思維體驗的?

哲學家稱之為「困難問題」,是心靈哲學中所謂心物問題的最新版本。[57]預支相關的一個問題是所謂意義或理解問題(哲學家稱之為「意向性」):思想與思考的對象(即對象與情境)之間的聯繫有什麼聯繫?第三個問題是經驗問題(或「現象學」):若兩個人看到同樣的事物,他們的體驗是否相同?還是說,「腦海里的東西」(稱作「感質」)有沒有可能因人而異?[58]

神經生物學家相信,隨着我們開始確定意識與神經的相關性,所有問題都將迎刃而解:頭腦中的機械機制與其集體屬性(如心智、經驗與理解)之間的實際關係。一些對人工智能持最嚴厲批評態度的人都認為,大腦只是一台機器,意識和智能都是愛中物理過程的結果。[59]這個棘手的哲學問題是:電腦程式在數字機器上運行時,本質上只是0與1的交換,它能複製神經元創造思維、心理狀態(如理解和感知)以及最終意識體驗的能力嗎?

關於計算機不可能有心智與心理狀態的論證

[編輯]瑟爾的中文屋

[編輯]約翰·瑟爾提出了一個思想實驗:假設現有一程序,通過了圖靈測試,並展現了一般的智能行為。具體來說,假設該程序能用流利的中文交談。把程序寫在3x5的卡片上,交給一個不會中文的普通人,把他關在房間裏,讓他按卡片上的指示操作。他將抄寫出漢字,並通過一個插槽進出房間。從外面看,這個中文屋裏似乎有個完全會說中文的聰明人。問題是:房間裏有人(或任何東西)懂中文嗎?也就是說,有沒有任何東西具有理解的心理狀態?有沒有任何東西能有意識地認識到正在用中文討論什麼?這個人顯然沒有我們所指的意識,房子本身也沒有意識,卡片當然也沒有意識。於是,瑟爾的結論是:中文屋或其他任何物理符號系統都不可能有心智。[60]

瑟爾繼續論證說,實際的心理狀態和意識需要(尚待描述)「實際人腦的實際物化屬性」。[61]他認為大腦和神經元具有特殊的「因果屬性」,從中產生了心智;用他的話說,就是「大腦導致心智」。[62]

相關討論:萊布尼茨磨坊、戴維斯的電話交換機、布洛克的中國民族和傻瓜實驗

[編輯]戈特弗里德·萊布尼茨(1714)很早就提出了與瑟爾基本相同的論點,他所用的思想實驗是將大腦擴大到磨坊大小。[63]Lawrence Davis(1974)設想用電話線和配備人員的辦公室來複製大腦;內德·布洛克(1978)設想讓整個中國的人口都參與這樣的大腦模擬。這個思想實驗被稱為「中國民族」或「中國體育館」。[64]內德·布洛克後來把中文屋歸結到「傻瓜實驗」,程序被再重構為一套「看這個,做那個」的簡單規則,消除了其中程序的所有神秘性。

對中文屋的回應

[編輯]對中文屋的回應強調了幾個不同的觀點。

- 系統回答與虛擬心智回答:[65]這個回答認為,包括人、程序、房間和卡片在內的整個系統,是理解了中文的東西。瑟爾稱,房間裏的那個人是唯一可能「有心智」或「有理解」的東西,但其他人則認為在同一個物理空間裏有可能存在兩個思想,就像一台計算機可以同時「是」兩台機器一樣:一台是物理的(如Mac機),一台是「虛擬機」(如文字處理器)。

- 速度、力量與複雜性回答:[66]一些評論家指出,房間裏的人可能要上百萬年時間才能回答一個簡單的問題,並且需要天文數字般的「檔案櫃」。這讓人對瑟爾直覺的清晰度產生了懷疑。

- 機械人回答:[67]有人認為,中文屋要真正理解需要眼和手。Hans Moravec寫道:「如果能把機械人嫁接到推理程序中,就不再需要人來提供這個意義了:它將來自物理世界。」[68]

- 大腦模擬器回答:[69]如果程序模擬的是真正會說中文的人的大腦突觸的神經發射序列呢?房間裏的人將模擬真實的大腦。這是「系統回答」的一種變體,看起來更可信,因為「系統」現在像人腦一樣運作。這似乎表明:除了房間裏的那個人之外,還有別的東西能聽懂中文。

- 他心回答與表象回答:[70]有幾位學者指出,瑟爾的論證只是他心問題的一個適用於機器的版本。既然很難確定人是否「真正」在思考,那麼很難回答關於機器的同樣問題就不值得驚訝。

- 一個相關問題是(瑟爾理解的)「意識」是否存在。瑟爾認為,意識體驗無法通過研究機器、人類或任何其他動物的行為來發現。丹尼爾·丹尼特指出,自然選擇只會保留對動物行為有影響的特徵,因此不可能產生(瑟爾理解的)意識。於是,要麼自然選擇沒有產生意識,要麼「強人工智能」是正確的,意識可以通過適當的圖靈測試檢測出來。

思考是一種計算嗎?

[編輯]心智計算理論(「計算主義」)稱,心智與大腦之間的關係類似於運行中的程序(軟件)與計算機(硬件)之間的關係。這一觀點在哲學上源於托馬斯·霍布斯(推理「不過是計算」)、戈特弗里德·萊布尼茨(試圖為人類所有想法創建邏輯微積分)、大衛·休謨(認為知覺可以簡化為「印象子」)甚至伊曼努爾·康德(將所有經驗分析為形式規則所控制)。[71]最新版本與哲學家希拉里·懷特哈爾·普特南和傑瑞·福多有關。[72]

如果人腦是一種計算機,那麼計算機就可以同時具有智能和意識,從而回答人工智能的實踐問題和哲學問題。就人工智能的實踐問題(「機器能否展現一般智能?」)而言,某些版本的計算主義聲稱(如霍布斯所寫):

- 推理不過是計算。[10]

即智能源於一種類似於算術的計算形式,這就是上文討論的物理符號系統假說,它意味着人工智能是可能的。就人工智能的哲學問題(「機器能否擁有心智、心理狀態與意識?」)而言,大多數計算主義版本都聲稱(Stevan Harnad描述):

- 心理狀態只是(正確的)電腦程式的實例化。[73]

這就是上文討論的約翰·瑟爾的「強人工智能」,也是(Harnad認為的)「中文屋」實驗的真正目標。[73]

其他相關問題

[編輯]機器可以有情緒嗎?

[編輯]若從對行為的影響或在生物體內發揮功能的方法的角度來定義,則「情緒」可視為智能體用來最大化行為效用的一種機制。漢斯·莫拉維克據此相信「一般來說機械人在做好事時相當情緒化」。[74]恐懼是緊迫感的來源。移情是好的人機交互必備的部分。他說,機械人「會以一種看似無私的方式取悅你,因為它可以從這種積極的強化中獲得快感。你可以把這理解為一種愛。」[74]Daniel Crevier寫道:「莫拉維克的觀點是,情緒只是將行為向利於物種生存的方向引導的工具。」[75]

機器可以有自我意識嗎?

[編輯]如上所述,「自我意識」有時被科幻作家用作人類本質屬性的名稱,能使物品成為完全的人類。圖靈剝離了人類的其他屬性,將問題簡化為「機器能否成為自己思想的主體?」它能思考自己嗎?從這個定義來看,能報告自身內部狀態的程序(如調試器)似乎具備這種「自我意識」。[76]

機器能否具有創造力?

[編輯]圖靈把這問題簡化為機器能否「出其不意」的問題,並認為這顯然是正確的,任何程式設計師都能證明。[77]他指出,只要有足夠的內存,計算機就能以天文數字級的不同方式運行。[78]對於一台能表示想法的計算機,以新方式組合想法一定是可能的,甚至是平凡的(例子如道格拉斯·萊納特的自動數學家將各種想法結合起來,發現了新的數學真理)。安德烈亞斯·卡普蘭和Haenlein認為,機器可以表現出科學創造力,而在藝術創造力方面,則人類很可能佔上風。[79]

2009年,亞伯大學和劍橋大學的科學家設計了一個名為亞當的機械人,他們認為這是第一個能獨立提出新科學發現的機器。[80]同樣是在2009年,康奈爾大學的研究人員開發了Eureqa程序,可以根據輸入的數據推斷公式,例如從鐘擺的運動中找出運動定律。

機器是仁慈的還是敵意的?

[編輯]這個問題(與人工智能哲學中的許多問題一樣)可以有兩種表述形式:「敵意」可由功能或行為定義,這樣「敵意」就是「危險」的同義詞;也可由意圖的角度來定義:機器能否「故意」造成傷害?後者是「機器有沒有意識狀態(意圖)?」的另一種形式。[53]

未來學家(如機器智能研究所)詳細研究了高度智能、完全自動的機器是否危險的問題。這話題也是諸多科幻作品中極其常見的戲劇性元素,使其大受歡迎。科幻作品考慮了智能機器對人類構成威脅的許多場景,參見虛構作品中的人工智能。

其中一個問題是,機器可能會很快獲得所需的自主性和智能,從而變得非常危險。弗諾·文奇認為,計算機的智能會在短短幾年內突然比人類高出成千上萬倍,他稱之為「技術奇點」。[81]他認為,這對人類可能非常危險。[82]一種名為「奇點主義」的哲學對此進行了討論。

2009年,學術界和技術專家召開了一次會議,討論機械人和計算機的可能影響,並在假設它們自動決策的可能性帶來的影響。他們討論了計算機和機械人獲得自主能力的可能性和程度,以及它們在多大程度上能用這種能力構成威脅。他們指出,一些機器已經獲得了某種形式的半自主能力,如能自行尋找電源、獨立選擇武器攻擊目標之類;一些電腦病毒能躲避消毒,實現了「蟑螂智能」。他們指出,科幻作品中描述的機器自我意識不太可能實現,但還有其他隱患。[81]

一些學者對賦予有一定自主能力的軍用機械人提出質疑。[83]美國海軍資助的一份報告指出,隨着軍用機械人變得越來越複雜,應更多關注其自主決策能力的影響。[84][85]

人工智能促進協會主席委託進行了一項研究,以探討這一問題。[86]他們指出,語言習得裝置等程序可以模擬人類互動。 有人認為有必要建立「友善人工智能」,也就是說人工智能已經取得的進步應包括在本質上走向友好與人性化。[87]

機器能否模仿人類的所有特徵?

[編輯]圖靈說「人們習慣於……以聲明的形式提供一絲安慰,即機器永遠無法模仿人類的某些特徵……我提供不了任何這樣的安慰,因為我相信無法設定這樣的界限。」[88]

圖靈指出,有許多論據的形式是「機器永遠不會做X」,但這些意見往往基於對機器多功能性的天真假設,或是「意識論證的變體」。編寫一個表現出一種X的程序「不會給人留下什麼印象。」[76]除非能證明這些X中的某個是一般智能必須的,否則都與人工智能的基本前提無關。

機器可以有靈魂嗎?

[編輯]最後,那些相信存在靈魂的人可能會說「思維是人類長生的靈魂的一種功能」。圖靈稱之為「神學異議」,寫道:

在試圖建造這樣的機器時,我們不應不敬地篡奪祂創造靈魂的權力,就像我們在生育孩子時一樣:相反,無論在哪種情況下,我們都是祂意志的工具,為祂創造的靈魂提供居所。[89]

最近,谷歌的LaMDA稱自己擁有知覺,且「有靈魂」,再次引發了對這一話題的討論。[90]

LaMDA是人工智能系統,會收集互聯網上的大量文本並用算法以最流暢、最自然的方式回答詢問,創造出聊天機械人——一種用於與人類交流的AI機械人。

科學家與LaMDA的對話記錄顯示,它在這方面表現很出色,能回答有關情感本質的挑戰性話題,生成伊索寓言式的故事,甚至描繪它所謂的恐懼。[91]幾乎所有的哲學家都對LaMDA的知能表示懷疑。 [92]

對哲學作用的看法

[編輯]有學者認為,AI界對哲學的否定是有害的。《斯坦福哲學百科全書》中,一些哲學家認為,哲學在AI中的作用沒有得到充分重視。[4]哲學家戴維·多伊奇認為,若不了解哲學或其概念,AI就會缺乏進展。[93]

參見

[編輯]註釋

[編輯]參考文獻

[編輯]- ^ Philosophy of Computer Science. obo. [2023-11-07]. (原始內容存檔於2023-08-27) (英語).

- ^ McCarthy, John. The Philosophy of AI and the AI of Philosophy. jmc.stanford.edu. [2018-09-18]. (原始內容存檔於2018-10-23).

- ^ Müller, Vincent C. Philosophy of AI: A structured overview. Nathalie A. Smuha (Ed.), Cambridge Handbook on the Law, Ethics and Policy of Artificial Intelligence. 2023-07-24 [2023-11-07]. (原始內容存檔於2023-07-24).

- ^ 4.0 4.1 Bringsjord, Selmer; Govindarajulu, Naveen Sundar, Artificial Intelligence, Zalta, Edward N. (編), The Stanford Encyclopedia of Philosophy Fall 2018, Metaphysics Research Lab, Stanford University, 2018 [2018-09-18], (原始內容存檔於2019-11-09)

- ^ Russell & Norvig 2003,第947頁將人工智能哲學定義為由前兩個問題和人工智能倫理組成。 Fearn 2007,第55頁寫道:「在目前的文獻中,哲學有兩個主要作用:一是確定這樣的機器的意識的存在性,二是預測這樣的機器的存在性。」最後一個問題與前兩個問題有關。

- ^ 6.0 6.1 這是圖靈測試基本要點的轉述。Turing 1950, Haugeland 1985,第6–9頁, Crevier 1993,第24頁, Russell & Norvig 2003,第2–3 and 948頁

- ^ 7.0 7.1 McCarthy et al. 1955。這一提議是達特茅斯會議(1956)的議程之一,被廣泛認為是「人工智能的誕生」。另參Crevier 1993,第28頁

- ^ 8.0 8.1 Newell & Simon 1976 and Russell & Norvig 2003,第18頁

- ^ 9.0 9.1 9.2 9.3 這個版本來自Searle (1999),Dennett 1991,第435頁亦引之。Searle最初的表述是:「適當編程的計算機確實構成意識,從這個意義上說,給計算機以正確的程序,就可以說計算機能理解、有其他認識狀態(Searle 1980,第1頁)。」Russell & Norvig (2003,第947頁)對強AI的定義類似:「哲學上,將機器有可能做出智能行為(更好的說法是:做出如有智能一般的行為)的論斷稱為'弱人工智能'假說,而把做出智能行為的機器實際上能思考(而不是模擬思考)的論斷稱為'強人工智能'假說。」

- ^ 10.0 10.1 Hobbes 1651,chpt. 5

- ^ See Russell & Norvig 2003,第3頁, where they make the distinction between acting rationally and being rational, and define AI as the study of the former.

- ^ Turing, Alan M. Computing Machinery and Intelligence. Mind. 1950, 49 (236): 433–460 [2020-10-18]. doi:10.1093/mind/LIX.236.433. (原始內容存檔於2021-12-22) –透過cogprints.

- ^ Heder, Mihaly; Paksi, Daniel. Autonomous Robots and Tacit Knowledge. Appraisal. 2012, 9 (2): 8–14 –透過academia.edu.[失效連結]

- ^ Saygin 2000.

- ^ Turing 1950,另見Russell & Norvig 2003,第948頁,他們稱圖靈的論文「很著名」,並寫道:「圖靈研究了對智能機器可能性的各種反對意見,包括論文發表後半個世紀內提出的幾乎所有反對意見。」

- ^ Turing 1950 under "The Argument from Consciousness"

- ^ Russell & Norvig 2003,第3頁

- ^ McCarthy 1999.

- ^ Russell & Norvig 2003,第4–5, 32, 35, 36 and 56頁

- ^ Russell和諾維格更傾向於用「理性主體」(rational)而非「智能(主)體」(intelligence)。

- ^ Artificial Stupidity. The Economist 324 (7770). 1 August 1992: 14.

- ^ Russell & Norvig (2003,第48–52頁)認為恆溫容器是智能體的最簡單形式,即所謂「反射智能體」。關於恆溫容器在哲學中作用的深入論述,請參Chalmers (1996,第293–301頁) "4. Is Experience Ubiquitous?" subsections What is it like to be a thermostat?, Whither panpsychism?, and Constraining the double-aspect principle.

- ^ Dreyfus 1972,第106頁.

- ^ Pitts & McCullough 1943.

- ^ Moravec 1988.

- ^ Kurzweil 2005,第262頁,另見Russell & Norvig,第957頁、Crevier 1993,第271 and 279頁。最極端形式(完全代替大腦的情形)由Clark Glymour於1970年代中期提出,Zenon Pylyshyn、約翰·瑟爾於1980年對其進行了論述。

- ^ Eugene Izhikevich. Eugene M. Izhikevich, Large-Scale Simulation of the Human Brain. Vesicle.nsi.edu. 2005-10-27 [2010-07-29]. (原始內容存檔於2009-05-01).

- ^ Dreyfus 1972,第194–5頁.

- ^ Searle 1980,第11頁.

- ^ Searle 1980,第7頁.

- ^ Yudkowsky 2008.

- ^ 瑟爾寫道:「我喜歡這種直截了當的說法。」Searle 1980,第4頁

- ^ Dreyfus 1979,第156頁

- ^ Gödel, Kurt, 1951, Some basic theorems on the foundations of mathematics and their implications in Solomon Feferman, ed., 1995. Collected works / Kurt Gödel, Vol. III. Oxford University Press: 304-23. - 在本講座中,哥德爾利用不完備定理得出了以下結論:(a) 人的思維不是一致有限機,或(b) 存在其無法決定解的存在性的丟番圖方程。哥德爾認為(b)不可信,於是人類思維不等同於一致有限機:人類思維的能力超過任何有限機。他承認這只是一種猜想,因為人們永遠無法推翻(b)。不過,他認為這個不相干的結論是「確切的事實」。

- ^ Lucas 1961, Russell & Norvig 2003,第949–950頁, Hofstadter 1979,第471–473,476–477頁

- ^ Graham Oppy. Gödel's Incompleteness Theorems. Stanford Encyclopedia of Philosophy. 2015-01-20 [2016-04-27]. (原始內容存檔於2021-05-03).

然而,這些哥德爾反機械論論證是有問題的,人們普遍認為它們是失敗的。

- ^ Stuart J. Russell; Peter Norvig. 26.1.2: Philosophical Foundations/Weak AI: Can Machines Act Intelligently?/The mathematical objection. Artificial Intelligence: A Modern Approach 3rd. Upper Saddle River, NJ: Prentice Hall. 2010. ISBN 978-0-13-604259-4.

……即使我們承認計算機在證明方面有局限性,也沒有證據表明人類可以不受之影響。

- ^ Mark Colyvan. An Introduction to the Philosophy of Mathematics. Cambridge University Press, 2012. From 2.2.2, 'Philosophical significance of Gödel's incompleteness results': "The accepted wisdom (with which I concur) is that the Lucas-Penrose arguments fail."

- ^ LaForte, G., Hayes, P. J., Ford, K. M. 1998. Why Gödel's theorem cannot refute computationalism. Artificial Intelligence, 104:265-286, 1998.

- ^ Russell & Norvig 2003,第950頁他們指出,具有有限記憶的真實機器可以用命題邏輯建模,其在形式上是可解的,哥德爾的論證根本不適用於它們。

- ^ Hofstadter 1979

- ^ 據Hofstadter 1979,第476–477頁,這句話最先由C. H. Whiteley提出

- ^ Hofstadter 1979,第476–477頁、Russell & Norvig 2003,第950頁、Turing 1950在《來自數學的論證》中寫道:「雖然已經確定任何特定機器的能力都有局限性,但只是有人說過,人類智力沒喲這種局限性,且沒有任何證據。」

- ^ Penrose 1989

- ^ Litt, Abninder; Eliasmith, Chris; Kroon, Frederick W.; Weinstein, Steven; Thagard, Paul. Is the Brain a Quantum Computer?. Cognitive Science. 2006-05-06, 30 (3): 593–603. PMID 21702826. doi:10.1207/s15516709cog0000_59

.

.

- ^ Dreyfus 1972, Dreyfus 1979, Dreyfus & Dreyfus 1986. See also Russell & Norvig 2003,第950–952頁, Crevier 1993,第120–132頁 and Fearn 2007,第50–51頁

- ^ Russell & Norvig 2003,第950–51頁

- ^ Turing 1950 under "(8) The Argument from the Informality of Behavior"

- ^ 49.0 49.1 Russell & Norvig 2003,第52頁

- ^ See Brooks 1990 and Moravec 1988

- ^ Daniel Kahneman. Thinking, Fast and Slow. Macmillan. 2011 [2012-04-08]. ISBN 978-1-4299-6935-2. (原始內容存檔於2023-03-15).

- ^ Crevier 1993,第125頁

- ^ 53.0 53.1 Turing 1950 under "(4) The Argument from Consciousness". See also Russell & Norvig 2003,第952–3頁, where they identify Searle's argument with Turing's "Argument from Consciousness."

- ^ Russell & Norvig 2003,第947頁

- ^ Blackmore 2005,第1頁.

- ^ 「人們總是告訴我很難定義意識,但我認為,如果你只是在找籌備階段的那種常識性定義,而非是總結階段的那種科學定義,那給意識下個常識性定義並不難。」 The Philosopher's Zone: The question of consciousness 互聯網檔案館的存檔,存檔日期2007-11-28.. Also see Dennett 1991

- ^ Blackmore 2005,第2頁

- ^ Russell & Norvig 2003,第954–956頁

- ^ 例如,約翰·瑟爾寫道:「機器能思考嗎?答案顯然是肯定的,我們正是這樣的機器。」 (Searle 1980,第11頁)

- ^ Searle 1980. See also Cole 2004, Russell & Norvig 2003,第958–960頁, Crevier 1993,第269–272頁 and Hearn 2007,第43–50頁

- ^ Searle 1980,第13頁

- ^ Searle 1984

- ^ Cole 2004,2.1, Leibniz 1714,17

- ^ Cole 2004,2.3

- ^ Searle 1980 under "1. The Systems Reply (Berkeley)", Crevier 1993,第269頁, Russell & Norvig 2003,第959頁, Cole 2004,4.1. Among those who hold to the "system" position (according to Cole) are Ned Block, Jack Copeland, Daniel Dennett, Jerry Fodor, John Haugeland, Ray Kurzweil and Georges Rey. Those who have defended the "virtual mind" reply include Marvin Minsky, Alan Perlis, David Chalmers, Ned Block and J. Cole (again, according to Cole 2004)

- ^ Cole 2004,4.2 ascribes this position to Ned Block, Daniel Dennett, Tim Maudlin, David Chalmers, Steven Pinker, Patricia Churchland and others.

- ^ Searle 1980 under "2. The Robot Reply (Yale)". Cole 2004,4.3 ascribes this position to Margaret Boden, Tim Crane, Daniel Dennett, Jerry Fodor, Stevan Harnad, Hans Moravec and Georges Rey

- ^ 引於Crevier 1993,第272頁

- ^ Searle 1980 under "3. The Brain Simulator Reply (Berkeley and M.I.T.)" Cole 2004 ascribes this position to Paul and Patricia Churchland and Ray Kurzweil

- ^ Searle 1980 under "5. The Other Minds Reply", Cole 2004,4.4. Turing 1950 makes this reply under "(4) The Argument from Consciousness." Cole ascribes this position to Daniel Dennett and Hans Moravec.

- ^ Dreyfus 1979,第156頁, Haugeland 1985,第15–44頁

- ^ Horst 2005

- ^ 73.0 73.1 Harnad 2001

- ^ 74.0 74.1 引於Crevier 1993,第266頁

- ^ Crevier 1993,第266頁

- ^ 76.0 76.1 Turing 1950 under "(5) Arguments from Various Disabilities"

- ^ Turing 1950 under "(6) Lady Lovelace's Objection"

- ^ Turing 1950 under "(5) Argument from Various Disabilities"

- ^ Kaplan Andreas; Michael Haenlein. Business Horizons. January 2019, 62 (1): 15–25. S2CID 158433736. doi:10.1016/j.bushor.2018.08.004.

- ^ Katz, Leslie. Robo-scientist makes gene discovery-on its own | Crave - CNET. News.cnet.com. 2009-04-02 [2010-07-29]. (原始內容存檔於2012-07-12).

- ^ 81.0 81.1 Scientists Worry Machines May Outsmart Man 互聯網檔案館的存檔,存檔日期2017-07-01. By JOHN MARKOFF, NY Times, 2009-07-26.

- ^ The Coming Technological Singularity: How to Survive in the Post-Human Era, by Vernor Vinge, Department of Mathematical Sciences, San Diego State University, (c) 1993 by Vernor Vinge.

- ^ Call for debate on killer robots 互聯網檔案館的存檔,存檔日期2009-08-07., By Jason Palmer, Science and technology reporter, BBC News, 8/3/09.

- ^ Science New Navy-funded Report Warns of War Robots Going "Terminator" 互聯網檔案館的存檔,存檔日期2009-07-28., by Jason Mick (Blog), dailytech.com, 2009-02-17.

- ^ Navy report warns of robot uprising, suggests a strong moral compass 互聯網檔案館的存檔,存檔日期2011-06-04., by Joseph L. Flatley engadget.com, 2009-02-18.

- ^ AAAI Presidential Panel on Long-Term AI Futures 2008-2009 Study 互聯網檔案館的存檔,存檔日期2009-08-28., Association for the Advancement of Artificial Intelligence, Accessed 7/26/09.

- ^ Article at Asimovlaws.com, July 2004, accessed 7/27/09. 互聯網檔案館的存檔,存檔日期2009-06039.

- ^ 'Can digital computers think?'. Talk broadcast on BBC Third Programme, 1951-05-15. http://www.turingarchive.org/viewer/?id=459&title=8[失效連結]

- ^ Turing 1950 under "(1) The Theological Objection", although he also writes, "I am not very impressed with theological arguments whatever they may be used to support"

- ^ Brandon Specktor published. Google AI 'is sentient,' software engineer claims before being suspended. livescience.com. 2022-06-13 [2022-06-14]. (原始內容存檔於2022-06-14) (英語).

- ^ Lemoine, Blake. Is LaMDA Sentient? — an Interview. Medium. 2022-06-11 [2022-06-14]. (原始內容存檔於2022-06-13) (英語).

- ^ M.Morioka et al. (2023-01-15) Artificial Intelligence, Robots, and Philosophy 互聯網檔案館的存檔,存檔日期2022-12-28., pp.2-4.

- ^ Deutsch, David. Philosophy will be the key that unlocks artificial intelligence | David Deutsch. the Guardian. 2012-10-03 [2018-09-18]. (原始內容存檔於2013-09-27) (英語).

引文

[編輯]- Adam, Alison (1989). Artificial Knowing: Gender and the Thinking Machine. Routledge & CRC Press. ISBN 978-0-415-12963-3

- Benjamin, Ruha (2019). Race After Technology: Abolitionist Tools for the New Jim Code. Wiley. ISBN 978-1-509-52643-7

- Blackmore, Susan, Consciousness: A Very Short Introduction, Oxford University Press, 2005

- Bostrom, Nick, Superintelligence: Paths, Dangers, Strategies, Oxford University Press, 2014, ISBN 978-0-19-967811-2

- Brooks, Rodney, Elephants Don't Play Chess (PDF), Robotics and Autonomous Systems, 1990, 6 (1–2): 3–15 [2007-08-30], CiteSeerX 10.1.1.588.7539

, doi:10.1016/S0921-8890(05)80025-9, (原始內容存檔 (PDF)於2007-08-09)

, doi:10.1016/S0921-8890(05)80025-9, (原始內容存檔 (PDF)於2007-08-09) - Bryson, Joanna (2019). The Artificial Intelligence of the Ethics of Artificial Intelligence: An Introductory Overview for Law and Regulation, 34.

- Chalmers, David J, The Conscious Mind: In Search of a Fundamental Theory, Oxford University Press, New York, 1996, ISBN 978-0-19-511789-9

- Cole, David, The Chinese Room Argument, Zalta, Edward N. (編), The Stanford Encyclopedia of Philosophy, Fall 2004 [2023-11-07], (原始內容存檔於2021-02-27).

- Crawford, Kate (2021). Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence. Yale University Press.

- Dennett, Daniel, Consciousness Explained, The Penguin Press, 1991, ISBN 978-0-7139-9037-9

- Dreyfus, Hubert, What Computers Can't Do, New York: MIT Press, 1972, ISBN 978-0-06-011082-6

- Dreyfus, Hubert, What Computers Still Can't Do, New York: MIT Press, 1979.

- Dreyfus, Hubert; Dreyfus, Stuart, Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer, Oxford, UK: Blackwell, 1986

- Fearn, Nicholas, The Latest Answers to the Oldest Questions: A Philosophical Adventure with the World's Greatest Thinkers, New York: Grove Press, 2007

- Gladwell, Malcolm, Blink: The Power of Thinking Without Thinking, Boston: Little, Brown, 2005, ISBN 978-0-316-17232-5.

- Harnad, Stevan, What's Wrong and Right About Searle's Chinese Room Argument?, Bishop, M.; Preston, J. (編), Essays on Searle's Chinese Room Argument, Oxford University Press, 2001 [2023-11-07], (原始內容存檔於2011-10-26)

- Haraway, Donna (1985). A Cyborg Manifesto.

- Haugeland, John, Artificial Intelligence: The Very Idea, Cambridge, Mass.: MIT Press, 1985.

- Hofstadter, Douglas, Gödel, Escher, Bach: an Eternal Golden Braid, 1979.

- Horst, Steven, The Computational Theory of Mind, Zalta, Edward N. (編), The Stanford Encyclopedia of Philosophy, Metaphysics Research Lab, Stanford University, 2009 [2023-11-07], (原始內容存檔於2018-09-11).

- Kaplan, Andreas; Haenlein, Michael, Siri, Siri in my Hand, who's the Fairest in the Land? On the Interpretations, Illustrations and Implications of Artificial Intelligence, Business Horizons, 2018, 62: 15–25, S2CID 158433736, doi:10.1016/j.bushor.2018.08.004

- Kurzweil, Ray, The Singularity is Near, New York: Viking Press, 2005, ISBN 978-0-670-03384-3.

- Lucas, John, Minds, Machines and Gödel, Anderson, A.R. (編), Minds and Machines, 1961 [2023-11-07], (原始內容存檔於2007-08-19).

- Malabou, Catherine (2019). Morphing Intelligence: From IQ Measurement to Artificial Brains. (C. Shread, Trans.). Columbia University Press.

- McCarthy, John; Minsky, Marvin; Rochester, Nathan; Shannon, Claude, A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, 1955, (原始內容存檔於2008-09-30).

- McCarthy, John, What is AI?, 1999 [4 December 2022], (原始內容存檔於4 December 2022)

- McDermott, Drew, How Intelligent is Deep Blue, New York Times, 1997-05-14 [2007-10-10], (原始內容存檔於2007-10-04)

- Moravec, Hans, Mind Children, Harvard University Press, 1988

- Penrose, Roger, The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics, Oxford University Press, 1989, ISBN 978-0-14-014534-2c

- Rescorla, Michael, "The Computational Theory of Mind", in:Edward N. Zalta (ed.), The Stanford Encyclopedia of Philosophy (Fall 2020 Edition) (頁面存檔備份,存於互聯網檔案館)

- Searle, John, Minds, Brains and Programs (PDF), Behavioral and Brain Sciences, 1980, 3 (3): 417–457, S2CID 55303721, doi:10.1017/S0140525X00005756, (原始內容 (PDF)存檔於2015-09-23)

- Searle, John, The Rediscovery of the Mind, Cambridge, Massachusetts: M.I.T. Press, 1992

- Searle, John, Mind, language and society, New York, NY: Basic Books, 1999, ISBN 978-0-465-04521-1, OCLC 231867665